مدلهای زبان بزرگ محلی (Local Language Models: LLMs) با ارائه جایگزینهایی انعطافپذیر، خصوصی و مقرونبهصرفه برای مدلهای هوش مصنوعی مبتنی بر ابر، انقلابی در تجربه توسعهدهندگان ایجاد کردهاند. این ابزارها نه تنها پشتیبانی قدرتمندی از کدنویسی ارائه میدهند، بلکه به نگرانیهای مربوط به حریم خصوصی و کارایی نیز پاسخ میدهند.

آزادسازی قدرت مدلهای زبان بزرگ محلی و مدلهای زبان کوچک برای کدنویسی

همچنان که هوش مصنوعی به انقلابی در چشمانداز کدنویسی ادامه میدهد، مدلهای زبان بزرگ محلی (LLMs) و مدلهای زبان کوچک (SLMs) به عنوان جایگزینهای قانعکنندهای برای راهحلهای محبوب مبتنی بر ابر مانند GitHub Copilot در حال ظهور هستند. این مدلها نه تنها کنترل و حریم خصوصی بینظیری را به توسعهدهندگان ارائه میدهند، بلکه صرفهجویی در هزینه و انعطافپذیری را برای طیف وسیعی از وظایف کدنویسی فراهم میکنند.

چرا مدلهای زبان بزرگ محلی در حال افزایش محبوبیت هستند

برخلاف راهحلهای میزبانی شده در ابر، مدلهای زبان بزرگ محلی که به صورت محلی مستقر میشوند، کاملاً در محیط شما عمل میکنند. این بدان معناست که توسعهدهندگان میتوانند از به اشتراک گذاشتن کد حساس یا اختصاصی با سیستمهای شخص ثالث اجتناب کنند، که این امر به ویژه برای سازمانهایی که تحت سیاستهای سختگیرانه حاکمیت دادهها هستند، بسیار مهم است. علاوه بر این، اجرای این مدلها به صورت محلی، هزینههای مکرر API را حذف میکند و تأخیر را کاهش میدهد و آنها را برای کسانی که تنظیمات سختافزاری قوی دارند، ایدهآل میکند.

مزایای کلیدی مدلهای زبان بزرگ محلی عبارتند از:

– حریم خصوصی: کد حساس در محیط محلی شما ایمن باقی میماند.

– سفارشیسازی: مدلها را میتوان برای گردشهای کاری خاص یا مجموعه دادههای اختصاصی تنظیم کرد.

– مقرونبهصرفه بودن: از هزینههای مکرر اشتراک ابر اجتناب کنید.

– تأخیر کم: زمان پاسخ سریعتر بدون تکیه بر سرورهای خارجی.

با این حال، اجرای یک LLM به صورت محلی نیازمند منابع محاسباتی قابل توجهی مانند پردازندههای گرافیکی (GPU) رده بالا یا پردازندههای مرکزی (CPU) چند هستهای با حافظه کافی است. این امر آنها را برای توسعهدهندگانی که به سختافزار پیشرفته دسترسی دارند، مناسبتر میکند.

چه چیزی مدلهای زبان کوچک را متفاوت میکند؟

مدلهای زبان کوچک (SLMs) نسخههای سادهسازی شده مدلهای زبان بزرگ هستند که سرعت و کارایی را در اولویت قرار میدهند. با پارامترهای کمتر، آنها برای وظایف سبک مانند تکمیل کد، اشکالزدایی ساده و نمونهسازی سریع بهینه شدهاند. در حالی که مدلهای زبان کوچک نمیتوانند پروژههای پیچیده یا در مقیاس بزرگ را به طور موثری مانند همتایان بزرگتر خود مدیریت کنند، در سناریوهایی که تأخیر کم و حداقل الزامات محاسباتی ضروری است، برتری دارند.

موارد استفاده قابل توجه برای مدلهای زبان کوچک:

– توسعه سیستمهای جاسازی شده: اجرا بر روی دستگاههایی با قابلیتهای سختافزاری محدود.

– برنامههای تلفن همراه: مدلهای نوظهور مانند OpenELM اپل قصد دارند مدلهای زبان کوچک را به تلفنهای هوشمند بیاورند.

– نمونهسازی سریع: ایجاد سریع پیشنویسها یا کدهای آماده.

انتخاب مدل مناسب برای نیازهای شما

انتخاب مدل زبان بزرگ محلی یا مدل زبان کوچک مناسب به نیازهای خاص و محیط توسعه شما بستگی دارد. در اینجا چند معیار و روش ارزیابی برای بررسی وجود دارد:

- HumanEval: توانایی یک مدل را برای تولید کد صحیح و کاربردی با حل ۱۶۴ مسئله برنامهنویسی ارزیابی میکند.

- MBPP: قابلیتهای کدنویسی چند زبانه را در زبانهای برنامهنویسی مختلف ارزیابی میکند.

- BigCodeBench: مدلها را در مورد وظایف درک و تولید کد در ۴۳ زبان برنامهنویسی آزمایش میکند.

- LiveCodeBench: معیارهای بهروزرسانی مداوم بر اساس مشکلات کدنویسی دنیای واقعی از پلتفرمهایی مانند LeetCode.

- EvoEval: چالشهای کدنویسی جدیدی را برای آزمایش سازگاری و جلوگیری از بیشبرازش ایجاد میکند.

در حالی که معیارهای عمومی نقطه شروع مفیدی را ارائه میدهند، اجرای معیارهای شخصی متناسب با گردشهای کاری معمول شما برای شناسایی مدلی که به بهترین وجه با نیازهای شما مطابقت دارد، بسیار مهم است.

برترین مدلهای زبان بزرگ محلی برای کدنویسی

در اینجا مجموعهای از برخی از امیدوارکنندهترین مدلهای زبان بزرگ محلی و مدلهای زبان کوچک موجود امروز ارائه شده است:

- DeepSeek V2.5: قابلیتهای مکالمه و کدنویسی را با پشتیبانی از حداکثر ۱۲۸ هزار توکن ترکیب میکند. ایدهآل برای پروژههای بزرگ که نیاز به زمینه گسترده دارند.

- Qwen2.5-Coder-32B-Instruct: یک مدل همهکاره که از ۹۲ زبان برنامهنویسی پشتیبانی میکند و در چندین معیار عملکرد خوبی دارد. در اندازههای مختلف پارامتر برای تنظیمات سختافزاری مختلف موجود است.

- Nxcode-CQ-7B-orpo: بهینه شده برای وظایف کدنویسی اساسی، این مدل تنظیم دقیق برای مبتدیان یا پروژههای کم پیچیدگی عالی است.

- OpenCodeInterpreter-DS-33B: در تفسیر کد پیشرفته و حل مسئله برتری دارد و آن را برای چالشهای پیچیده کدنویسی مناسب میکند.

- Artigenz-Coder-DS-6.7B: سبک و در دسترس، این مدل برای نمونهسازی سریع بر روی سختافزار میان رده عالی است.

چالشها و محدودیتها

در حالی که مدلهای زبان بزرگ محلی مزایای قابل توجهی ارائه میدهند، با مجموعهای از چالشهای خود همراه هستند:

- الزامات سختافزاری: اجرای مدلهای پیچیده به صورت محلی نیازمند GPU های رده بالا است که میتواند بسیار گران باشد.

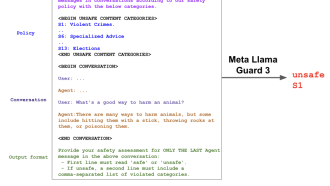

- خطرات امنیتی: حتی تنظیمات محلی نیز در صورت عدم رعایت اقدامات احتیاطی مناسب در برابر حملات سایبری آسیبپذیر هستند.

- شکافهای عملکرد: علیرغم وعده آنها، مدلهای زبان بزرگ محلی هنوز از نظر قابلیتهای خام و سهولت استفاده از راهحلهای مبتنی بر ابر مانند GPT-4 عقب هستند.

در حال حاضر، مدلهای زبان بزرگ محلی به عنوان ابزارهای مکمل به جای جایگزین برای دستیارهای کدنویسی هوش مصنوعی رایج در نظر گرفته میشوند. با این حال، با ادامه سرمایهگذاری جوامع متنباز و شرکتهایی مانند اپل و متا در این فضا، این شکاف در حال کاهش است.

مسیر پیش رو

ظهور مدلهای زبان بزرگ محلی و مدلهای زبان کوچک نشاندهنده یک تغییر هیجانانگیز به سمت ابزارهای هوش مصنوعی خصوصیتر و قابل تنظیمتر برای توسعهدهندگان است. در حالی که این مدلها ممکن است هنوز با عملکرد غولهای مبتنی بر ابر رقابت نکنند، جایگزین قانعکنندهای برای کسانی هستند که به دنبال کنترل بیشتر بر گردشهای کاری خود هستند.

با نگاه به آینده، پیشرفتها در دسترسی به سختافزار و بهینهسازی مدل احتمالاً راهحلهای محلی را حتی بیشتر قابل اجرا میکند. با بلوغ اکوسیستم، توسعهدهندگان به ابزارهای قدرتمندتر دسترسی خواهند داشت که بهترین عملکرد، حریم خصوصی و انعطافپذیری را با هم ترکیب میکنند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: the new stack