خب بذار از یه سوال ساده شروع کنم: اگه یه ربات یا پهپاد رو بندازی وسط یه محیطی که همهچی معلوم نیست و کامل نمیتونه ببینه یا بفهمه، چطور باید تصمیم بگیره کار درست رو انجام بده؟ مثلاً فرض کن یه پهپاد قراره توی جنگل چیزی پیدا کنه اما نمیتونه همهجا رو همزمان ببینه. این جور کارها رو بهش میگن مسائل «Perception-Related»؛ یعنی کارهایی که به درک و تشخیص محیط ربط دارن.

این مقاله که خیلی تازه هم هست (توی arXiv منتشر شده) دقیقاً میره سراغ همین مشکل! قضیه اینه که تو این محیطهایی که بهشون میگن «محیطهای جزئی مشاهدهپذیر» یا POMDP (یعنی Partially Observable Markov Decision Process، مدلی ریاضی که توش ربات فقط یه تیکه از اطلاعات رو داره و باید بر اساس همون تصمیم بگیره)، پیدا کردن یه سیاست کنترل درست و حسابی خیلی سخته. “سیاست” تو این فاز هم یعنی اون برنامهریزی که ربات بر اساسش تصمیم میگیره چه کاری انجام بده.

حالا برای اینکه بتونن به این رباتها هدفهای پیچیدهتری بدن، یه زبان منطقی جدید به اسم sc-iLTL معرفی کردن! (sc-iLTL یعنی co-safe linear inequality temporal logic که خیلی خلاصه بگم: زبانیه که هدفهای چند مرحلهای و پیچیده رو میشه توش با عبارتهای ریاضی و منطقی – مخصوصاً نابرابریهای خطی – تو فضای باور (belief space) تعریف کرد. “فضای باور” هم یعنی اون چیزی که ربات فکر میکنه احتمالاً تو محیط داره اتفاق میافته).

ولی خب خودشون میگن این تعریف هدفهای پیچیده با sc-iLTL رو چطور به یه مسئلهی سادهتر تبدیل کردن! کاری که کردن اینه که هدفهای تعریفشده با sc-iLTL رو تبدیل میکنن به یه هدف ساده به اسم «رسیدن به یه نقطه خاص» یا Reachability. یعنی بجای پیروی خط به خط از منطق پیچیده، ربات فقط باید تلاش کنه برسه به اون نقطهای که براش تعریف شده.

برای این کار، از ترکیب دو مفهوم استفاده کردن: یکی «محصول فضای باور» (belief MDP) و یکی «دستگاه متناهی قطعی» (Deterministic Finite Automaton؛ یه جور مدل ریاضی ساده برای چک کردن هدفهای منطقی)، که با هم یه مدل قویتر میسازن تا ربات چیزی رو که میخوایم دقیقتر بره سمتش. اما اینجا یه مشکل هست؛ وقتی این دوتا رو با هم ضرب میکنی، مدل خیلی بزرگ و سنگین میشه و ربات زورش نمیرسه همه حالتها رو حساب کنه.

اینجاست که یه تکنیک خفن و هوشمندانه وارد کار میشه به اسم جستوجوی درختی مونت کارلو یا MCTS! حالا MCTS همون روشیه که تو بازیهایی مثل شطرنج هوش مصنوعی باهاش حرکت بعدی رو انتخاب میکنه. اینجا کمک میکنه تا ربات بدون اینکه همه حالتها رو یکی یکی چک کنه، با یه جور شبیهسازی و تصادفیسازی، به بهترین سیاست نزدیک بشه. خلاصه شبیه اینه که چند صد بار سناریوها رو تو ذهنش امتحان میکنه و آخرش تقریباً بهترین راه حل رو پیدا میکنه.

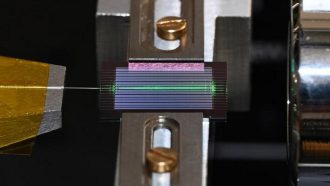

در نهایت، نویسندهها رفتن روش خودشون رو روی یه پرنده پهپادی (drone-probing case study) آزمایش کردن؛ یعنی به سبک پروژههای واقعی، سیستم رو دادن دست یه پهپاد تا نشون بدن روششون فقط رو کاغذ نیست و تو عمل هم جواب میده!

در کل، نتیجه بحث اینه که با ترکیبی از زبان منطقی sc-iLTL، ساخت مدل ترکیبی و استفاده از MCTS میشه برای رباتها تو شرایط پر ریسک و دید ناکامل، سیاستهایی ساخت که بتونن هدفهای پیچیده رو محقق کنن؛ تازه نه فقط آسون، بلکه بهینه هم باشه!

خلاصه اگر برات مهمه هوش مصنوعی چطور تو محیطهای نصفهنیمه و یه جوری غیرقابل پیشبینی کار میکنه، این مقاله یه ترکیب خیلی تازه و خلاق از منطق، کنترل و الگوریتم است. واقعاً ارزش خوندن داره!

منبع: +