اگه تا حالا دوست داشتی وسط اون همه فایل و سند شرکت، هر سوالی داشتی رو راحت ازشون جواب بگیری، این خبر خیلی برات جالبه! یه تیم به اسم eSapiens یه سیستم جدید طراحی کردن به اسم ماژول DEREK که واقعاً کارش حرف نداره.

DEREK مخففه Deep Extraction & Reasoning Engine for Knowledge، یعنی یه موتور حسابی عمیق برای استخراج و استدلال روی اطلاعات. قراره با این سیستم هر سوالی داشتی درباره اسناد شرکت، خیلی راحت و امن جوابش رو بگیری. حالا بریم ببینیم این سیستم چیکار میکنه و چرا اینقدر خاصه!

اول اینو بگم که کل ماجرا درباره «Retrieval-Augmented Generation» هست، یعنی ترکیب هوش مصنوعی با جستجو بین اسناد.

ماجرا از اینجا شروع میشه که شما کلی سند داری (مثلاً PDF، فایلهای آفیس، سایتها و غیره). حالا DEREK میاد اینا رو میخونه و هر سند رو تیکه تیکه (مثلاً هر ۱۰۰۰ تا کلمه یه chunk درست میکنه) و هر بخش رو با بخش قبلی یه مقدار همپوشانی میده. این یعنی بخشهای مختلف اطلاعات رو از دست نمیده و هر گزاره مهم دوباره تو تیکه بعد هم هست و ازش رد نمیشه.

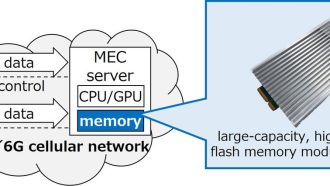

بعدش برای اینکه این تیکهها راحتتر پیدا بشن، همه رو تو یه سیستم ذخیرهسازی خاص میذاره که اسمش Hybrid HNSW+BM25 هست. اگه این اسم برات عجیب بود، نگران نباش: HNSW یه مدل برای جستجوی سریع دادههاست و BM25 هم یه روش تخصصی برای پیدا کردن سندهای مرتبط؛ اینها رو ترکیب میکنن که هم دقت بالا بره هم سرعت.

حالا وقتی شما سوالت رو میپرسی، اول از همه این سوال رو میدن به GPT-4o (یه مدل جدید هوش مصنوعی خیلی پیشرفته شده از سمت OpenAI)، تا سوالت رو دقیقتر و روونتر کنه. یعنی اگه سوالت یه کم گنگ یا ناقص باشه، GPT-4o میگه چی مدنظرته و شفافترش میکنه.

بعد از این مرحله، سیستم با همون ترکیب خاص (vector+BM25) دنبال بهترین بخشهای اسناد میگرده که به سوالت مربوط باشه. بعدش، سیستم Cohere میاد و دوباره همه نتایج رو ردهبندی میکنه (Cohere هم یه مدل هوش مصنوعی برای پردازش زبانه که تمرکزش روی درک معنای متن ـه).

وقتی اسناد درست و مرتبط پیدا شدن، کلی اطلاعات جمع شده و نوبت جواب دادن با کمک LLM هست. LLM یعنی Large Language Model، مدلهای زبانی خیلی بزرگ مثل همون ChatGPT که خودش میتونه جواب بنویسه. اما اینجا از یه تکنیک خاص به اسم CO-STAR prompt engineering استفاده میشه، یعنی روشهایی برای اینکه مدل هوش مصنوعی دقیقتر جواب بده و کمتر پرت بگه.

خوب اینجا داستان تموم نمیشه. یه قسمت خیلی خیلی مهم به اسم LangGraph Verifier هم به سیستم اضافه کردن. این قسمت وظیفهش اینه که جواب نهایی رو چک کنه و مطمئن بشه هر چیزی که مدل گفته، واقعاً تو اسناد بوده. مثلاً اگه مدل چیزی گفته که تو هیچ بخش سند نیست، جواب رو برمیگردونه و میگه “از اول!” تا وقتی که توی جواب، هر ادعا یا حرف، واقعاً یه سند پشتش باشه. این کار باعث میشه جواب، پشتیبانی مستند داشته باشه.

از نظر امنیت هم حسابی قرص و محکم هست! مثلاً همه اجزای سیستم رو به شکل کانتینر (Container) اجرا کردن — کانتینر یعنی یه جور بستهبندی نرمافزاری که میشه راحت جابجاش کرد و منابعش امنه. کل ارتباطات سیستم هم با TLS 1.3 و AES-256 رمزنگاری میشه (اینها یعنی سطح بالای امنیت واسه جلوگیری از دزدیدن یا تغییر اطلاعات!).

یه نکته باحال اینه که کل این ماجرا خیلی خوب تو شرکتها جواب میده و مخصوص کارهای حساسه، مثلاً تو حوزه حقوقی یا مالی که اشتباه اصلاً قابل قبول نیست. چون باید جوابها دقیق و مطمئن و قابل ردیابی باشن.

بیایید یه کمم در مورد نتایج آزمایشی حرف بزنیم: تو چهار دسته از دیتاستهای LegalBench (دادگاه مجازی برای تست سیستمهای هوشمند)، این ۱۰۰۰ تکهای کردن سندها، باعث شد که یه واحد درصد Recall@50 بره بالا (یعنی تو ۵۰تا نتیجه اول، اطلاعات درست بیشتری پیدا میشه – Recall یعنی بازیابی اطلاعات مرتبط). ترکیب هیبرید و ردهبندی هم دقیقاً ۷ درصد Precision@10 رو بالا برد (Precision یعنی بین ۱۰ جواب اول، دقت بالاتر رفت).

قسمت LangGraph Verifier هم عدد TRACe Utilization رو بالای ۰.۵۰ آورد (TRACe یعنی استفاده از منابع و سندها به شکل درست) و تعداد جوابهایی که هیچ پشتیبانی نداشتن رو زیر ۳ درصد نگه داشت. یعنی ۹۷٪ جوابها مطمئناً رفرنس درست داشتن!

در مجموع، این ماژول DEREK برای سازمانهایی که اطلاعات حساس دارن و باید همیشه همه چیز امن، قابل پیگیری و دقیق باشه، یه انتخاب فوقالعادهست. کارایی بالایی داره، سربار عملیاتی کمی داره و میشه حسابی بهش اطمینان کرد، حتی تو زمینههایی مث حقوق و امور مالی که اشتباه، هزینهبرداره.

خلاصه: اگه دنبال یه موتور پرسشوپاسخ داینامیک برا اسناد شرکتت میگردی که هم خیلی امن باشه هم جوابای دقیق و قابل پیگیری بده و حسابی هم چراغ قرمز بذاره جلوی هر ادعای بیپشتوانه، DEREK دقیقاً همون چیزیه که میخوای!

منبع: +