خب بذار از یه مشکلی شروع کنیم که خیلیامون باهاش برخورد کردیم: فحاشی و آزار و اذیت آنلاین. این موضوع واقعاً تو فضای مجازی خیلی شایع شده، هم تو کامنتهای شبکههای اجتماعی و هم تو دایرکتا. ولی بیشتر تحقیقاتی که تا حالا انجام دادن، فقط روی فحاشیهایی که همه میتونن ببینن (یعنی پستها و کامنتهای عمومی) تمرکز داشتن. کسی خیلی سراغ پیامهای خصوصی نرفته بود!

ولی حالا تصور کن توی دایرکت اینستاگرام، آدما پیامهای آزاردهنده دریافت کنن و هیچ سیستمی درست و حسابی نباشه که بتونه این پیامها رو اتوماتیک تشخیص بده یا جواب مناسبی بده. اینجاست که یه تیم باحال اومده و از Large Language Models یا همون مدلهای زبونفهم بزرگ (مثلاً ChatGPT، ابزارای قوی هوش مصنوعی که میتونن متن بخونن و تولید کنن) استفاده کرده تا این مشکل رو حل کنن.

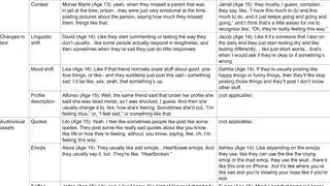

داستان اینطوریه: اول اومدن یه تیم از آدمهای واقعی رو استخدام کردن تا کلی پیام دایرکت اینستاگرام رو بخونن و اونایی که توش آزار و اذیت بود رو برچسب بزنن. منظور از برچسب زدن اینه که مشخص کنن چه پیامی فحاشیه، چه پیامی نه. خب این کار واقعاً زمانبر و گرونه.

اینا اومدن مدل زبون بزرگشون رو آموزش دادن که خودش همون کار رو اتوماتیک انجام بده! یعنی دیگه نیازی نباشه همیشه آدم واقعی بشینه بخونه. جالبیش اینه که مدل هوش مصنوعی اینا فقط متن رو نمیبینه، بلکه گفتوگوها و پیامهای قبلش رو هم بررسی میکنه تا بفهمه دقیقاً جریان از چه قراره. مثلاً یه جوک وسط دعوا میتونه فحاشی باشه یا نباشه، بستگی به قبل و بعدش داره.

بعد از این مرحله، اومدن مقایسه کردن ببینن که هوش مصنوعی چقدر مثل آدمیزاد داره درست تشخیص میده. نتیجه؟ مدلشون واقعاً خوب عمل کرده و تونسته فحاشیها رو تو این پیامای خصوصی پیدا کنه.

ولی خب فقط تشخیص مزاحمت کافی نیست! قدم بعدیشون این بود که ببینن هوش مصنوعی میتونه جواب درست و مفیدی هم به این آزاردهندهها بده یا نه. یعنی وقتی یکی پیام آزاردهنده فرستاد، مدل یه پاسخ مناسب و پخته بسازه که هم اوضاع رو آروم کنه، هم به اون کسی که اذیت شده کمک کنه حس بهتری داشته باشه.

در نهایت، یه مقایسه باحال انجام دادن؛ یعنی جوابهایی که مدل هوش مصنوعی تولید میکرد رو با جوابهای واقعی آدما با هم مقایسه کردن. چی شد؟ جوابای شبیهسازی شدهی مدل، از نظر کمکرسانی و مفید بودن، حتی بهتر از جوابهای واقعی بودن!

خلاصه اگر بخوایم قضیه رو جمعبندی کنیم، این تیم نشون دادن که امروزه با تکنولوژی مدلهای زبونفهم بزرگ، میشه خیلی هوشمندانهتر و سریعتر آزار و اذیتهای آنلاین، مخصوصاً تو دایرکتها و پیامهای خصوصی، رو هم شناسایی کرد، هم جواب مناسب بهشون داد. این میتونه یه قدم بزرگ واسه امنیت و حس خوب کاربران تو فضای مجازی باشه. مخصوصاً برای جاهایی مثل اینستا که خیلی از آدما حوصله یا انرژی بحث و جواب دادن ندارن!

راستی مدل زبون بزرگ یا همون Large Language Model، یعنی یه جور هوش مصنوعی که کلی متن خونده و میتونه معنی جملات رو بفهمه و حتی خودش متنهای جدید و منطقی بنویسه. این یاروها تو زمینه ساخت چتبات، فیلتر محتوا، یا حتی کمک به حل مشکلات اجتماعی مثل فحاشی آنلاین خیلی کارآمدن.

در کل، هوش مصنوعی اومده که فقط سرعت نشون بده یا سرگرم کنه نه؛ داره کمکم تبدیل میشه به یه سپر دفاعی واقعی برای دنیای آنلاین ما!

منبع: +