احتمالاً این روزا دیگه کمتر کسی هست که اسم مدلهای زبانی مثل ChatGPT یا باقی مدلهای هوشمند جدید رو نشنیده باشه. این مدلها که بهشون میگن “Small language models”، یعنی مدلهای زبانی کوچیک، خیلی محبوب شدن چون نسبتاً سریع و جمع و جور کار میکنن، ولی با امکانات باحال!

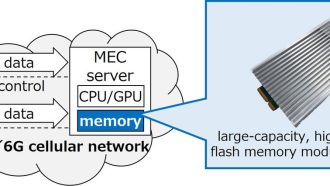

حالا یه مسئله مهم پیش میاد: اگه بخوای بهشون اطلاعات بیشتری مثل تصویر و ویدئو هم بدی (که به این حالت میگن “multimodal” یا چند-مداله)، بعضی وقتا ناخواسته کلی اطلاعات اضافی یا نویز هم وارد مدل میشه. نویز همون اطلاعات اضافیه که هیچ به درد سوال و جواب نمیخوره و فقط مدل رو گیج میکنه و تمرکزش رو کم میکنه. مخصوصاً وقتی “context window” یا پنجره متنی مدل محدوده، یعنی فقط میتونه یه مقدار محدود از اطلاعات رو همزمان بررسی کنه، این نویزها بیشتر دردسر درست میکنن.

تحقیقات جدید نشون دادن که “mechanism attention” (مکانیسم توجه/تمرکز مدلها) توی Transformerها (اون نوع مدل هوش مصنوعی مشهوری که برای متن و تصویر استفاده میشه) معمولاً بخش زیادی از حواسشون رو الکی روی اطلاعات بیربط میذارند! مثلاً به جای اینکه به جواب درست دقت کنه، مفاهیم اضافی رو جدی میگیره و خطاها (که بهشون hallucination هم میگن. Hallucination یعنی مدل چیزهایی میگه یا جوابهایی میسازه که واقعیت ندارن یا از خودش درمیاره!) زیاد پیش میاد.

این وسط یه ایده خفن به اسم “Differential Attention” اومده بود که قبلاً فقط تو مدلهای متنی (text-only) استفاده میشد. خلاصه Differential Attention یعنی یه راه هوشمندتر برای تمرکز مدل که کمکش میکنه بیخودی حواسش پرت نشه و نویز رو از اطلاعات مفید تشخیص بده. واژه differential هم یعنی تفاوتی یا متفاوت نگاه کردن.

تو این مقاله که الان دربارهش صحبت میکنیم، تیم تحقیقاتی اومده و Differential Attention رو آورده سراغ یه مدل جدید با نام “PaliGemma” که مدل ترکیبی متن و تصویر هست (یعنی هم متن میفهمه هم تصویر رو میتونه تحلیل کنه). اونا با یه تکنیک به اسم LoRA (که خودش یه جور شیوه هوشمندانه برای تربیت دوباره و بهینه کردن مدلهاست بدون اینکه همه چیزش رو از اول آموزش بدی)، مدل PaliGemma 3B رو با Differential Attention تنظیم و تست کردن.

تیم تحقیق هم مدل رو با تنظیمات مختلف تست کردن تا بفهمن کدوم حالت بهتر جواب میده… هدفشون این بود ببینن آیا واقعاً این مکانیسم Differential Attention میتونه جلوی نویز و تولید اطلاعات اشتباه (hallucination) رو بگیره یا حداقل کمترش کنه؟

نتیجه خیلی جالبه: نشون دادن که Differential Attention کاملاً میتونه به مدلهای چند-مداله اضافه بشه و در فرآیند “فاینتیونینگ” یا همون بهبود مدلهای فعلی کاربرد داشته باشه تا مدلها کمتر گیج شن و اطلاعات دقیقتری برای سوال و جواب پیدا کنن. خلاصه به زبون ساده یعنی مدل هوش مصنوعی هم دقیقتر میشه هم کمتر حرف الکی میزنه!

در کل این مقاله میگه که حتی اگه مدل هوش مصنوعی براتون کوچیک و جمع و جوره، با یه سری راهکارهای هوشمندانه مثل Differential Attention (که کمک میکنه مدل فقط به اطلاعات درست دقت کنه و کمتر گیج بشه)، میشه از مدلهای چند-مداله مثل PaliGemma نهایت استفاده رو برد و جوابهای بهتر گرفت. دیگه وقتشه مدلهاتون رو به یه نسخه دقیقتر ارتقا بدید!

منبع: +