خب بیا با هم یکم از پشت پردهی تکنولوژیهای جدید مرتبط با هوش مصنوعی حرف بزنیم، مخصوصاً اون دعوایی که سر حافظهها و سرعت و مصرف انرژی وجود داره! همه جا صحبت از HBM هست – اینو بهش میگن High Bandwidth Memory یعنی حافظههایی با پهنای باند بالا که توی کارای سنگین مثل آموزش (training) مدلهای هوش مصنوعی حسابی مهم شدن. اما این وسط D-Matrix و چندتا شرکت دیگه دارن راه خودشونو میرن.

یه مدت پیش Sandisk و SK Hynix با هم اومدن و توافق کردن یه حافظه جدید به اسم High Bandwidth Flash بسازن که میشه گفت یه جور جایگزین ارزونتر و انعطافپذیرتر برای HBM ـه. این حافظه جدید قراره ظرفیتای بیشتری بیاره و هزینه رو کاهش بده مخصوصاً برای شتابدهندههای هوش مصنوعی که همیشه دنبال حافظه بیشتر و سریعترن.

حالا D-Matrix اومده و داره یه ایده کاملا متفاوت رو تست میکنه. اکثر شرکتا تمرکزشون رو روی آموزش مدلها با HBM گذاشتن، اما D-Matrix گفته «بیاید یه نگاه بزنین به بخش inference!» — یعنی همون جایی که مدل یادگرفته و حالا میخواد جواب بده و پیشبینی کنه. Inference توی هوش مصنوعی یعنی همون بخش جوابگویی مدل، نه آموزش دادن.

محصول اصلیشون اسمش Corsair ـه. این Corsair از یه آرشیتکتور چیپلت-محور (chiplet-based) استفاده میکنه که ۲۵۶ گیگابایت LPDDR5 داره (این حافظههای DDR معمولی لپتاپایه، اما نسل جدیدشون که فوق سریعن) و ۲ گیگابایت SRAM (اینم یه مدل حافظه سریع برای نگهداری موقت دادههاست). به جای اینکه برن سراغ HBM گرون و کمیاب، اومدن باهم آکسلریتورهای مختص AI و DRAM رو توی یه پکیج کنار هم گذاشتن تا فاصله بین پردازش و حافظه کم بشه.

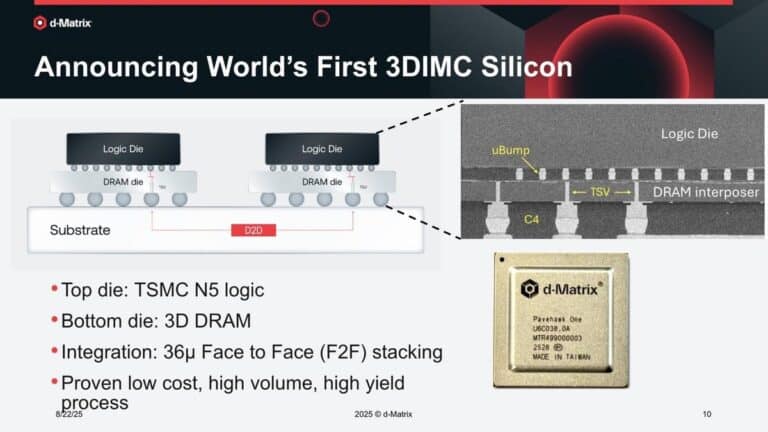

یه تکنولوژی دیگهای هم دارن به اسم Pavehawk که کلی ادعا داره: مثلاً با ترکیب DRAM سهبعدی و لاجیک (منظور همون منطقی که پردازش کارها رو انجام میده) روی یه چیپ، تونستن مشکل «دیوار حافظه» رو تا حد زیادی حل کنن. “Memory Wall”، یعنی جایی که سرعت حافظه دیگه جوابگوی نیاز پردازنده برای داده نیست و باید یه فکر اساسی بشه. توی این طرح، قراره انتقال دادهها خیلی سریعتر و مصرف انرژی خیلی کمتر باشه. اونها میگن حتی ۱۰ برابر پهنای باند بیشتر و ۱۰ برابر بازدهی انرژی بالاتر نسبت به HBM دارن!

پلتفرم Pavehawk روی تراشه لاجیک TSMC N5 ساخته شده (TSMC N5 یعنی نسل ۵ نانومتری کارخانه چیپسازی معروف تایوان) و روش چندتا DRAM سهلایه به صورت سهبعدی قراردادن. اینطوری حافظه تقریبا چسبیده به پردازنده میشه و کلی زمان و انرژی توی رفت و آمد دادهها صرفهجویی میشه.

این ایده اصلاً جدید هم نیست! شرکتای دیگهای هم سراغ اتصال نزدیکتر حافظه و پردازنده رفتن، مثلاً با کنترلر اختصاصی یا استانداردهای اتصال مثل CXL (اینم یه جور کابل و پروتکل برای وصل کردن سریع حافظه و پردازندهست). اما D-Matrix یه قدم جلوتر رفته و داره سیلیکون اختصاصی (منظور تراشه سفارشی) برای بهینهسازی قیمت و مصرف انرژی ارائه میده.

چرا همه دارن تلاش میکنن HBM رو دور بزنن؟ خب چون قیمت این نوع حافظه وحشتناک بالاست و همیشه هم کمیابه. مثلاً شرکتای خیلی بزرگ مثل Nvidia راحت HBM سطح بالا میخرن، اما بقیه یا شرکتای کوچیکتر مجبورن سراغ ماژولای ارزونتر برن که کندتر و داغترن. نتیجهش؟ رقابت نابرابر!

حالا اگر D-Matrix واقعاً بتونه هم ظرفیت بالا و هم قیمت مناسب ارائه بده، بازی رو برای همه عادلانهتر میکنه! مخصوصاً برای دیتا سنترهایی که میخوان کلی سیستم inference راه بندازن و هزینه حافظه براشون مهمه.

حالا همه اینا رو گفتیم، این تکنولوژیها فعلاً توی ابتدای راهن. خود D-Matrix هم میگه “یه سفر چندساله در پیش داریم!”. قبلاً هم شرکتای زیادی سعی کرده بودن «دیوار حافظه» رو فروریخته کنن، اما واقعاً معدودیشون تونستن بازار رو به هم بزنن.

از طرف دیگه چون این روزها ابزارهای هوش مصنوعی و مخصوصاً LLM ها (Large Language Models یعنی مدلهایی مثل ChatGPT و گوگل بارد که حجم اطلاعات خیلی زیادی دارن) دارن همهگیر میشن، نیاز به سختافزار مقیاسپذیر برای inference بیشتر حس میشه. حالا باید دید بالاخره Corsair و Pavehawk ـشون یه انقلاب درست میکنه یا فقط یه آزمایش جذاب باقی میمونه!

خلاصه، جنگ اصلی بین حافظههای قدیمی و این ایدههای جدید ادامه داره، ولی معلومه هوش مصنوعی رو به سمت «سریعتر، ارزونتر و کممصرفتر» بودن هل میده!

منبع: +