احتمالاً تو هم مثل خیلیهای دیگه حسابی با ChatGPT یا بقیه چتباتهای هوش مصنوعی یعنی همون رباتهایی که باهات حرف میزنن، سر و کله زدی. جالبه بدونی الان نزدیک ۲۰۰ میلیون نفر هر روز بیش از یه میلیارد سؤال و درخواست به این چتباتها میفرستن! خب شاید فکر کنی این چتباتها از خودشون جواب درمیارن، اما واقعیت اینه که پشت پرده همه این فرایندها حسابی انرژی مصرف میشه و کلی برق میسوزونه.

یه نکته جالب: توی سال ۲۰۲۳، دیتاسنترها یا همون مراکز دادهای که کار آموزش و پردازش هوش مصنوعی رو انجام میدن، مسئول ۴.۴ درصد مصرف برق کل آمریکا بودن. در سطح جهانی هم حدود ۱.۵ درصد کل مصرف برق دنیا مال این مراکز دادهست. نکته ترسناکتر اینجاست که انتظار میره این عددها تا سال ۲۰۳۰ حداقل دو برابر بشه، اونم فقط به خاطر رشد تقاضا برای هوش مصنوعی!

الکس دیوریس-گائو (Alex de Vries-Gao)، کارشناس پایداری فناوریهای نوظهور توضیح داده بود: «سه سال پیش اصلاً خبری از ChatGPT نبود، اما الان داریم درباره تکنولوژیای حرف میزنیم که قراره تقریباً نصف مصرف برق دیتاسنترهای دنیا رو به خودش اختصاص بده!»

حالا چی باعث میشه این چتباتهای هوشمند اینقدر پرمصرف باشن؟ قضیه برمیگرده به مقیاس عظیم کارشون. توی هوش مصنوعی دو مرحله هست که برق زیادی میبره: آموزش (Training) و استنتاج (Inference). آموزش یعنی مدلهای زبان بزرگ مثل همون مدلهایی که ChatGPT و Gemini دارن، رو با کلی داده تغذیه میکنن تا الگوها و پیشبینیها رو یاد بگیرن. اینا همون Large Language Models هستن یا به اختصار LLM، یعنی مدلهایی که حجم عظیمی از داده رو میخورن تا بتونن جواب بدن.

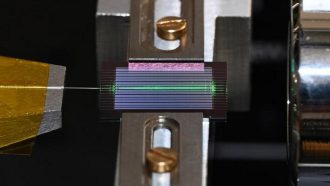

کلاً توی دنیای هوش مصنوعی، یه باور وجود داره که هرچی مدل بزرگتر باشه (و داده بیشتر بخوره)، جوابهای دقیقتری هم میتونه بده. اما این بزرگکردن مدل کلی سر و صدا داره! مثلاً مدلهای جدید اونقدر بزرگ شدن که حتی توی یه کارت گرافیک حرفهای یا حتی توی یه سرور جا نمیشن. مجبورن چندین سرور با چندتا GPU یعنی همون کارتهای گرافیکی قدرتمند رو با هم قفل کنن و هفتهها یا حتی ماهها اینا رو روشن نگه دارن. این یعنی چه؟ یعنی مصرف برقِ نجومی! فقط فکر کن، یه سرور Nvidia DGX A100 میتونه تا ۶.۵ کیلووات برق بخوره! برای آموزش یه مدل LLM باید کلی سرور داشت که هرکدوم معمولاً ۸ تا GPU دارن. تازه اینا ممکنه هفتهها و ماهها مشغول باشن.

یه تخمین جالب: برای آموزش مدل GPT-4 کمپانی OpenAI حدود ۵۰ گیگاواتساعت برق مصرف شده! یعنی میتونی با این میزان برق کل سانفرانسیسکو رو ۳ روز روشن نگه داری.

حالا فکر نکن وقتی مدل آموزش دید، دیگه قضیه تمومه! مرحله استنتاج یا Inference یعنی همون زمانی که چتبات پاسخ سؤال کاربر رو میده – که مصرف برق توی این مرحله هم کمه؟ اصلاً! چون علاوه بر اینکه مدلها غولآسا هستن، تعداد درخواستها هم خیلی زیاده. فقط OpenAI گفته واسه چتبات خودش روزانه بیش از ۲.۵ میلیارد درخواست جواب میده! این یعنی مدام باید کلی سرور روشن باشه تا مردم هر سؤالی داشتن سریع جواب بگیرن. اینهمه مصرف برق فقط واسه چتباتهای معروفه. مثلاً گوگل هم گفته قراره Gemini رو بهزودی توی جستجوگرش پیشفرض کنه، یعنی درخواستها بیشتر و بیشتر میشه.

مشرَف چودری (Mosharaf Chowdhury)، دانشمند حوزه کامپیوتر از دانشگاه میشیگان میگه: «حتی توی استنتاج هم نمیتونیم واقعاً انرژی زیادی ذخیره کنیم، چون حجم عظیمی از مردم دارن از این مدلهای غولآسا استفاده میکنن.»

جالب اینجاست که خیلی از محققها دنبال اینن دقیقتر بفهمن این هوش مصنوعیها چقدر انرژی میخورن و چطوری میشه مصرف رو کم کرد. مثلاً آقای چودری یه جدول آنلاین با اسم ML Energy Leaderboard درست کرده که نشون میده هر مدل اوپنسورس چقدر برق توی مرحله استنتاج مصرف میکنه. اما شرکتهای بزرگ مثل گوگل و مایکروسافت و متا اصلاً این عددها رو شفاف اعلام نمیکنن یا فقط یه سری اطلاعات ناقص میدن که واقعاً نفهمی ضرر زیستمحیطی چقدر جدیه. اینطوری اصلاً معلوم نمیشه هوش مصنوعی دقیقاً چقدر برق میخوره و آیا واقعاً دنیا میتونه از پس این روند بر بیاد یا نه!

در هر حال، کاربران میتونن فشار بیارن تا شرکتها شفافتر عمل کنن و این موضوع هم واسه محافظت از محیط زیست مهمه، هم باعث میشه هر کسی انتخاب بهتری برای استفاده از هوش مصنوعی داشته باشه. به گفته دیوریس-گائو: «بزرگترین مشکل اینجاست که تاثیر این ابزارهای دیجیتال اصلاً شفاف نیست. حالا نوبت سیاستگذارا و نهادهای نظارتیاست که قاعده بذارن تا شرکتها مجبور به شفافسازی بشن و کاربران هم بتونن کاری کنن.»

خلاصه، دنیای هوش مصنوعی خیلی باحال و خفن شده، ولی یادت باشه پشت پرده این تکنولوژیها یه عالمه برق مصرف میشه که باید حواسمون بهش باشه و از شرکتها شفافیت و مسئولیتپذیری بیشتری بخوایم!

منبع: +