حتماً شما هم دیدین که امروزه خبرای جعلی یا همون فیکنیوزها دارن فضای مجازی رو پر میکنن و خب خیلی وقتا تشخیصشون واقعاً کار راحتی نیست. حالا فکر کنین یه سیستم باشه که بتونه این فیکنیوزها رو تو زبونها و شکلای مختلف (هم متن، هم عکس!) تشخیص بده و تازه توضیح بده که چرا فکر میکنه یه خبر فیکه یا نیست. خیلی باحاله نه؟

تا همین چند وقت پیش، بیشتر مدلایی که واسه شناسایی فیکنیوز ساخته بودن فقط انگلیسی بلد بودن، فقط متن رو میخوندن و اصلاً نمیشد فهمید از روی چی به نتیجه رسیدن. اما یه تحقیق جدید اومده دو تا کار بزرگ انجام داده که خیلی میتونه راه رو عوض کنه:

اولیش یه دیتاست عظیم ساختن از ۷۴ هزار خبر به پنج تا زبون مختلف: هندی، گجراتی، مراتی، تلوگو و البته انگلیسی. هر خبر هم کنار متنش عکس داره که معلوم شه مدل فقط روی متن حساب نمیکنه. (دیتاست یعنی مجموعه داده ها؛ مثلاً کلی خبر کنار هم که بخوای روشون مدل بسازی.)

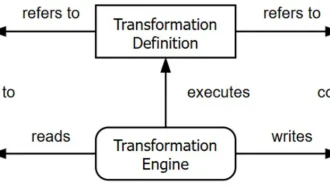

نوآوری دوم سیستم HEMT-Fake بود! اسمش یه کم عجیبه ولی بیاین ساده بشکنیمش:

- این سیستم متن رو با یه ساختار پیچیده میفهمه که اسمش ترکیبی از ترنسفورمر، CNN و BiLSTMـه (خب ترنسفورمر و اینا یعنی مدلای خیلی قوی هوش مصنوعی که میتونن معنی و مفهوم رو از متن بکشن بیرون.)

- بعد تصویر خبر رو هم با کمک یه شبکه عصبی بهاسم ResNet آنالیز میکنه. (ResNet هم یه مدل تخصصی برای فهم عکس و اجزای جزئی اون.)

- اطلاعات متادیتا، مثل اینکه نویسنده کیه یا اصل منبع چیه هم با روشی به اسم GraphSAGE مدل میشه (GraphSAGE یعنی یه مدل شبکهای که ارتباط بین دادههای مختلف رو همزمان بررسی میکنه.)

- همه اینا آخرش با چیزی به اسم attention ترکیب میشن که ببینن کدوم بخشها بیشتر به درد تشخیص میخورن. (Attention یعنی توجه مدل به بخشهای مهمتر دادهها.)

خوبیش اینه که HEMT-Fake فقط نتیجه «درسته یا غلطه» نمیده، خودش میتونه توضیح بده چرا این تصمیم رو گرفته! واسه این کار سه تا تکنیک باحال کنار هم گذاشتن: واسه کدوم کلمه، کدوم جمله یا حتی متن یا عکس، مدل از چی برداشت کرده. SHAP و LIME هم دوتا روش معروف توضیحپذیر کردن مدلن، یعنی مدل میگه دقیقاً کجاها باعث شدن خبر رو فیک یا واقعی درنظر بگیره.

این سیستم ۵ درصد از مدلای قبلی مثل XLM-R و mBERT تو چهار تا زبون پیشرفت کرده. مخصوصاً تو زبونایی که کمتر دیتا دارن (مثلاً هندی یا تلوگو)، اختلاف ۷ تا ۸ درصدی داره! (XLM-R و mBERT هم مدلای معروف مولتیزبان عصبیان که معمولاً واسه متن به کار میرن.)

ولی فقط اینجا تموم نمیشه! HEMT-Fake میتونه تو شرایط سخت هم درست کار کنه. مثلاً اگه فیکنیوز رو بیان با جملهبندیهای جدید (یعنی Paraphrase کنن) بازم ۸۵ درصد دقت داره! تازه رو خبرای فیک تولیدشده با هوشمصنوعی هم تا ۸۰ درصد درست تشخیص میده. این یعنی نصف سیستمهای قدیمی خطا میزنن، ولی این مدل خیلی مقاومتره.

آخراش هم از همه مهمتر: اومدن گفتن این توضیحهایی که مدل میده واقعاً به درد میخورن یا نه. آدمها خودشون بررسی کردن و ۸۲ درصد وقتا گفتن توضیحهای مدل «معنادار و کمککنندهاس»!

خلاصه، این سیستم جدید واقعاً میتونه به Fact-checkerها یا همون کسانی که صحت خبرها رو بررسی میکنن کمک کنه که سریعتر و مطمئنتر فیکنیوزها رو پیدا کنن و دلیلش رو هم راحت بفهمن! به نظرتون آینده فیکنیوز با مدلای اینطوری جمع میشه؟

منبع: +