تا حالا فکر کردی یه روز رباتها بتونن مثل آدمها فکر کنن و رفتار کنن؟ خب، دیگه اون روز خیلی دوره نیست! گوگل DeepMind یه آپدیت اساسی توی هوش مصنوعی مخصوص رباتها معرفی کرده که اسمشون رو گذاشتن Gemini Robotics 1.5 و Gemini Robotics-ER 1.5. این دو مدل قراره رباتها رو چند پله هوشمندتر کنن.

قبلاً هم گوگل یه مدل معرفی کرده بود به اسم Gemini مخصوص رباتیک که بر پایه LLM (Large Language Model) یا همون مدلهای زبان مصنوعی بزرگ ساخته شده بود. خلاصه این مدل، رباتها رو از گرفتن فرمانهای ساده مثل “موز رو بذار توی سبد” به جایی رسوند که بتونن کارای عملیاتی ساده انجام بدن. ولی حالا نسخۀ جدیدترش اومده که واقعاً قضیه رو تغییر داده!

داستان از کجا شروع شد؟ گوگل برای تست اولیه، همون مثال موز گذاشتن تو سبد رو آورد. قبلاً ربات فقط همین کار رو میتونست. ولی حالا با Gemini Robotics 1.5، دیگه ربات میتونه از چندتا میوه مختلف مثل موز، سیب و لیمو، هر کدوم رو بر حسب رنگشون جدا کنه و توی بشقاب مناسب بذاره. یعنی هم میبیند، هم تشخیص میده، هم میفهمه کدوم میوه واسه کدوم ظرفه! تازه موقع کار کردن هم توضیح میده چرا این کارو انجام میده. مثلاً میگه: “این موز زرده، پس میذارمش تو بشقاب زرد”. کلی باحاله، نه؟

یکی از محققای DeepMind به اسم Jie Tan میگه: «ما عملاً به ربات قدرت تفکر دادیم. حالا میتونه محیطشو ببینه، گام به گام فکر کنه و کارای چند مرحلهای رو کامل انجام بده. این فقط یه نمونهست، در آینده رباتها کارای خیلی پیچیدهتری انجام میدن». منظورش اینه که دیگه با همون مغز میتونه وارد کارای روزمره و پیچیدهتر هم بشه.

حالا این مدلها چجوری با هم کار میکنن؟ بزار ساده بگم: Gemini Robotics-ER 1.5 حکم “مغز” رو داره. این مدل چیزی به اسم Vision-Language Model یا VLM هست – یعنی مدلهایی که هم تصویر میفهمن و هم زبان طبیعی رو میخونن. این مغز محیط و اجسام توش رو میشناسه، فرامین و دستورها رو میخونه و تحلیل میکنه، بعد هم فرمان رو به دست ربات میسپره. دستها و چشمهای ربات، یعنی همون Gemini Robotics 1.5 به عنوان Vision-Language-Action Model یا VLA وارد عمل میشن. این مدل دستور رو با چیزی که دوروبرش میبینه تطبیق میده و بعد قدم به قدم اجرا میکنه و حتی موقع اجرا بازخورد و توضیح هم میده. حالا هر دو مدل با هم مثل یه سوپروایزر و کارگر تیمی کار میکنن!

نکته جالب اینجاست که این رباتها حتی میتونن از اینترنت و ابزارهایی مثل Google Search استفاده کنن. مثلاً تو یه تست، محققا از ربات خواستن بر اساس قوانین بازیافت شهر سانفرانسیسکو، زبالهها رو به دستههای کمپوست (زباله طبیعی تجزیهشونده)، بازیافت و زباله عادی تقسیم کنه. ربات اول مکان فرد رو تشخیص داد، بعد قوانین همون شهر رو از اینترنت پیدا کرد و بر اساس اون کیسهها رو تو سطل درست گذاشت! یعنی نه فقط حرف میفهمه و تصویر، بلکه خودش میره تحقیق هم میکنه!

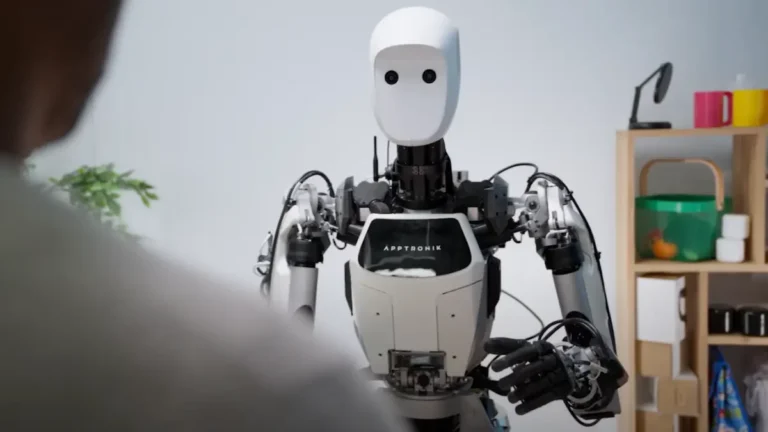

یه برتری دیگه این مدلها اینکه هر چیزی که توی یه ربات (مثلاً Aloha 2 که دو تا بازوی رباتیکه) یاد میگیرن، میتونن توی رباتای دیگه مثل Apollo (ربات انساننما) یا Franka (ربات دو بازویی) هم استفاده کنن. یعنی یادگیری عمومی دارن و هر ربات از تجربههای دیگری بهرهمند میشه.

نکته خفن آخرم اینه که این رباتا فقط توی شرایط ایستاده و ثابت قوی نیستن، بلکه وقتی محیط تغییر میکنه، مثلاً یکی میاد لباسا یا سطلها رو جابجا میکنه، باز هم فضا رو آنی میبینن و تصمیم درست میگیرن. تو یه نمونه آزمایش، از Apollo خواستن لباسای سفید رو یک طرف بزاره و بقیه رنگا رو یه طرف دیگه. توی وسط کار، لباسها و سطلها رو جابجا کردن و ربات دوباره همه چیز رو تحلیل و کار رو درست انجام داد!

در کل هدف اینه که رباتها بتونن کارای سخت روزمره رو با درک عمیق، تفکر مرحلهای، و کنترل خیلی دقیق انجام بدن. اینجوری دیگه لازم نیست واسه هر کار ساده یه مدل اختصاصی ساخته بشه. تکنولوژی داره به جایی میرسه که شاید بزودی ربات توی خونهمون واقعا یه دستیار باهوش و انعطافپذیر باشه!

اگه دوست داشتی بیشتر بدونی بد نیست بدونی همین DeepMind تونسته رباتی بسازه که تو پینگپنگ از انسانها هم بهتر بازی میکنه یا هوش مصنوعی دیگهای که فقط با یه دوربین میتونه کنترل کامل یه ربات رو یاد بگیره! پس اینا فقط یه تیکه کوچیک از آینده باحالیه که داریم بهش نزدیک میشیم.

منبع: +