حتماً این روزا همه جا حرف هوش مصنوعی یا همون AI هست، مخصوصاً وقتی قرار باشه تو کارهای مهم و حساس کنار آدما باشه. یه سؤال بزرگ این وسط هست: آدما چطور بفهمن که کی باید به توصیهی AI گوش بدن و اصلاً چقدر باید بهش اعتماد کنن؟ راستش این تحقیق همین موضوع رو بررسی کرده و نتایج جالبی هم داشته.

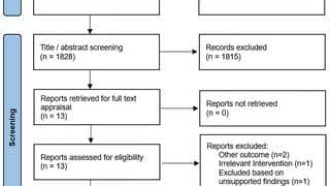

بیاین یه کم راحتتر و خودمونی بهش نگاه کنیم. محققها اومدن و یه آزمایش ترتیب دادن. ۱۲۰ نفر رو جمع کردن و بهشون یه کار دادن: باید میفهمیدن که درآمد یه نفر بالاتر از یه مقدار خاص هست یا نه (یه جور تست پیشبینی درآمد). حالا این وسط مدل AI کمکم کار رو سختتر و جالبتر کرد. یعنی چی؟ چهار جور راهنمایی مختلف برای آدمها گذاشت:

۱. فقط حدس مدل رو بهشون میداد (مثلاً میگفت: درآمد این شخص بالاس یا پایینه).

۲. حدس مدل + اینکه این پیشبینی رو با چند درصد اطمینان گفته (مثل وقتی یکی میگه: «تموم نشده، ۸۰٪ مطمئنم!»).

۳. همه اطلاعات قبلی + اینکه مدل تو هر دسته چقدر موفق بوده (مثلاً Recall یعنی چقدر درست تشخیص داده افرادی که واقعاً درآمد بالایی داشتن – یه جور آمار کارایی مدل رو هم میداد).

۴. همه اطلاعات بالا + توضیح میداد که هر ویژگی چقدر برای مدل مهم بوده (این کار توی AI بهش میگن Feature Importance – یعنی مثلا مدل توضیح میداد تحصیلات یا سن چقدر روی پیشبینی درآمد تاثیر گذاشته).

توی هر مرحله، وضعیت آدمها و مدل فرق میکرد: بعضی وقتا شرکتکنندهها مطمئن بودن، بعضی وقتا خودشون دودل بودن؛ همینجوری مدل هم درجات اعتماد به پیشبینیاش رو نشون میداد. علاوه بر سنجش اینکه پیشنهادا چقدر درست بودن (دقت پیشبینی)، محققها از شرکتکنندهها پرسیدن چقدر به مدل «اعتماد کردن»، چقدر «فهمیدن» مدل چیکار میکنه و چقدر احساس کردن میتونن بهش تکیه کنن. تازه، یهجور امتحان هم دادن تا بفهمن واقعاً توضیحای مدل رو متوجه شدن یا نه!

خب حالا نتیجه چی شد؟ اول از همه باید بگم فقط همینکه مدل نشون بده چقدر به پیشبینی خودش مطمئنه (یعنی همون نشون دادن میزانی از «عدم قطعیت» یا Uncertainty Estimate)، میتونه کمک کنه که آدما وقتی شک دارن، تصمیم بهتری بگیرن. یعنی وقتی خود آدم دودل بود اما مدل با اعتماد بنفس بالا یه پیشبینی ارائه میداد، طرف بیشتر احتمال داشت که بزنه تو خال!

اما جالبترش اینه که توضیحات کاملتر مدل (مثل اینکه بگه چه ویژگیهایی براش مهم بوده)، باعث شد شرکتکنندهها مدل رو خیلی بهتر بفهمن و حتی، بدون اینکه دقت کلی پیشبینیها کم بشه، توی امتحانای فهم ویژگیها موفقتر باشن (مثلاً اینکه بگن دقیقاً چی باعث شده مدل این تصمیم رو بگیره، یا اینکه اگه یه ویژگی عوض شه، مدل امکان داره چی پیشبینی کنه – اینو میگن Counterfactual Reasoning).

نکته مهم دیگه اینه که هم اعتماد بنفس خود آدمها و هم سطح اعتماد مدل روی رابطهشون با AI تاثیر بزرگی داره. یعنی اگه مدل خیلی مطمئن باشه اما خود فرد هم خودش رو بینقص بدونه، لزوماً کمک مدل رو گوش نمیده. برعکس، اگه خود فرد شک داشته باشه و مدل محکم پیشبینی بده، بهترین پیشرفت توی نتیجهها دیده شد. تو سه تا از چهار شرایط آزمایش، دقیقاً همینجا بود که آدمها بیشترین سود رو از همکاری با مدل بردن.

در نهایت چیزی که این مطالعه نشون داد این بود که نشون دادن عدم قطعیت (یا uncertainty) و ارائه توضیحهای کامل (explanations)، هردو دسته بهدسته تو همکاری آدم و هوش مصنوعی نقش دارن؛ یکی باعث میشه پیشبینیها دقیقتر شن، یکی هم کمک میکنه کاربر بهتر بفهمه مدل از رو حساب و کتاب چیزها رو گفته. اعتماد به نفس آدما یه جور نقش واسطه (moderator) بازی میکنه که باید تو طراحی سیستمهایی که میخوان به آدما تو شرایط حساس کمک کنن، مد نظر قرار بگیره.

در کل، اگه میخواین هوش مصنوعی کنارتون باشه و واقعاً بهتون کمک کنه، فقط کافی نیست که فقط خوب پیشبینی کنه؛ باید بلد باشه توضیح بده و نشون بده خودش چقدر به جواباش مطمئنه. اینجوری هم کاربرا راحتتر باهاش کنار میان، هم تصمیمای دسته جمعی تو موقعیتهای مهم خیلی بهتر میشن.

منبع: +