بذارین یه سوال ساده بپرسم: اگه یه سیستم هوش مصنوعی (مثلاً همونهایی که تصاویر تولید میکنن یا متنو جمعبندی میکنن) بهمون یه جواب عجیب بده، چجوری میتونیم بفهمیم چرا این کارو کرده؟ تقریباً همه سیستمهای هوش مصنوعی جدید از چند تا «کامپوننت» (یعنی قسمت یا بخش مختلف سیستم) و کلی منبع داده تشکیل شدن. خلاصه کارشون اینه که مثل یه تیم بزرگ عمل میکنن که هرکدوم یه کاری دارن.

حالا اینجا یه «اصطلاح باحال» هست به اسم Data Provenance. یعنی چی؟ یعنی اطلاعات مربوط به تاریخچهی دادهها: مثلاً اینکه این داده اولش کجا بوده، چه تغییرهایی روش انجام شده و چطوری به این نتیجه رسیده شده. این Provenance یه جورایی میتونه به ما کمک کنه بفهمیم هرچی که آخر کار از سیستم درمیاد، چجوری بهش رسیدیم. ولی خب، راستشو بخواین، Provenance خیلی وقتها اونقدر ریز و فنی و پراکندهست که کاربرا (یعنی آدمهایی مثل ما که میخوان جوابو بفهمن) گیج میشن و اصلاً نمیتونن ازش استفاده کنن.

تو این مقاله، نویسندهها یه ایدهی باحال رو مطرح کردن: میگن بیا یه دستیار هوشمند و تعاملی (یعنی هوش مصنوعی که باهات حرف میزنه و جواب سوالاتو میده) بسازیم که با خود کاربر همکاری کنه تا با هم توضیح بسازیم. یعنی کاری کنیم که توضیح دادن خروجیهای هوش مصنوعی فقط از روی Provenance نباشه بلکه با نظر و سوالات کاربر هماهنگ باشه. اینجوری کاربر هم واقعا چیزی که براش مهمه رو میفهمه و هم مطمئنه حرفی که بهش میزنیم واقعا ریشه تو دادهها و Provenance داره.

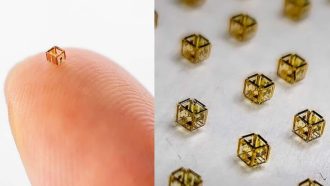

حالا چجوری این ایده رو نشون دادن؟ اول یه نمونه اولیه (Prototype یعنی نسخهی اولیه و آزمایشی هر محصول یا نرمافزاری) از این دستیار رو ساختن. این دستیار، با کاربرها تعامل میکنه، سوالاشونو میگیره، و سعی میکنه بر اساس Provenance جواب درست و منطقی بده. مثلاً اگه ازش بپرسی چرا این هوش مصنوعی این نتیجه رو گرفت، با توجه به مسیر دادهها و فرایندهای داخلی یکی یکی توضیح میده، ولی خلاصه و واضح.

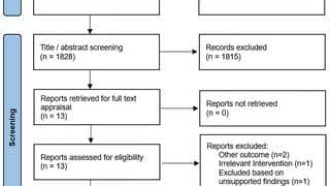

بعدش واسه اینکه ببینن این مدل جدید چقدر خوبه، یه چارچوب ارزیابی (Framework یعنی روشی سیستماتیک برای چک کردن عملکرد یه چیز) طراحی کردن که میشه روش بزرگش کرد و روی مجموعههای داده و سناریوهای مختلف تستش کرد. این چارچوب شامل یه عالمه شبیهسازی کاربری (یعنی فرض کردن نقش آدمهای واقعی توی تستها) و استفاده از مدلهای زبانی قوی مثل LLMها به عنوان “قاضی”ه. منظور از LLM (Large Language Model) مدلهای زبانی خیلی بزرگ مثل GPT هست که میتونن متن رو بفهمن و قضاوت کنن.

در کل حرف این مقاله اینه که اگه میخوایم کاربرا واقعاً سیستمهای هوش مصنوعی رو بفهمن و بهشون اعتماد کنن، باید کاری کنیم که توضیحات خروجیها هم کاربرپسند باشه، هم واقعاً براساس تاریخچهی دادهها باشه. یعنی یه جادوی ترکیبی! این مدل دستیار هوشمند که با Provenance کار میکنه، همون چیزیه که گره از کار خیلیا باز میکنه.

خلاصه اگه با هوش مصنوعی سر و کار دارین، یا براتون توضیحِ کارکرد این سیستمها مهمه، این ایده یه قدم مهمه برای اینکه خروجیها هم منطق داشته باشن هم قابل فهم باشن. دیگه لازم نیست بین توضیح دادن فنی و توضیح کاربرپسند یکی رو انتخاب کنین؛ میشه جفتشو با هم داشت!

منبع: +