این روزها دیگه ساختن ویدیوهای جعلی یا همون دیپفیکها خیلی راحتتر از قبل شده، مخصوصاً با وجود هوش مصنوعیهای پیشرفتهٔ Generative AI (یعنی هوش مصنوعیای که میتونه خودش محتوا مثل عکس یا ویدیو تولید کنه). این موضوع باعث شده دیگه نمیتونیم هر ویدیویی رو بدون شک به عنوان «حقیقت» قبول کنیم. Abe Davis که استادیار علوم کامپیوتر توی Cornell هست، خیلی خوب میگه: «قبلاً ویدیوها منبع حقیقت بودن، ولی الان دیگه نمیتونیم به این موضوع اطمینان کنیم، چون هر کسی میتونه هر ویدیویی که بخواد بسازه!»

پس یه مشکل جدی پیش اومده. چطور بفهمیم یه ویدیو واقعیه یا با ترفند و هوش مصنوعی دستکاری شده؟ جوابش دست یه تیم خلاق از دانشگاه Cornell هست که روش باحالی پیدا کردن: واترمارکگذاری نامرئی با نور موقع ضبط ویدیو!

حالا این دقیقاً یعنی چی؟ اغلب تکنیکهای قبلی واترمارک اینگونه بودن که باید فایل ویدیویی رو دیجیتالی علامتگذاری میکردی، اما این کار خیلی وقتا عملی نیست یا تولیدکنندههای ویدیو همکاری نمیکنن. روش جدید اما، به جای اینکه توی فایل دست ببرن، نور محیط رو موقع ضبط ویدیو خیلی نامحسوس تغییر میدن تا یه کد مخفی توی فیلم جا بندازن. یعنی نور میتابه اما توی چشم ما هیچ تغییری دیده نمیشه، چون تغییراتش انقدر ریزه که حسش نمیکنیم.

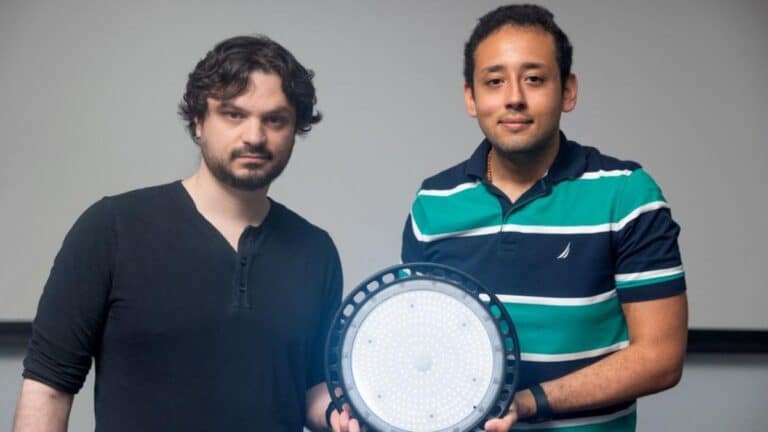

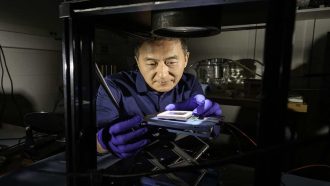

برای این کار حتی میتونن به راحتی روی لامپهای معمولی، چراغ استودیو یا حتی مانیتور کامپیوتر یه چیپ کوچیک (تقریباً هم اندازه تمبر پستی) وصل کنن که بلده نور رو به صورت رمزی تغییر بده! Peter Michael که یکی از دانشجوهای پرتلاش این پروژهست، میگه: «ما کلی مطالعه روی اینکه چشم آدم به نور چطور حساسه کردیم و تونستیم نوری طراحی کنیم که هم شبیه نویزهای تصادفی معمولیه (نویز یعنی اختلالات عادی که توی نور هست)، هم اینکه فقط با رمز خودش قابل شناسایی باشه.» این یعنی تقلبکارها هم نمیتونن راحت کد رو پیدا کنن!

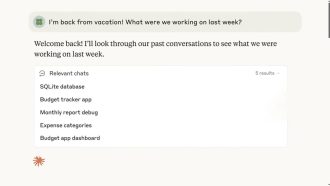

حالا فایده این کدها چیه؟ فرض کن کسی فیلم یه مصاحبه یا سخنرانی سیاستمدار رو دستکاری کنه، مثلاً بخشی رو حذف کنه یا چیزی بهش اضافه کنه. اگه دست تحلیلگر متخصص باشه و به رمز کد اون نور دسترسی داشته باشه، راحت میفهمه کجای فیلم حذف یا اضافه شده. حتی اگه یه بخش دستکاری شده باشه، توی «کد ویدیو» (یعنی نسخهی سادهتر و کمکیفیتتری از فیلم که تغییرات نور توش معلومه) بخش اضافه یا تغییر یافته معمولاً سیاه یا غیرطبیعی دیده میشه.

این سیستم فقط روی یه نور هم محدود نمیشه؛ بچههای کورنل تونستن تا سه منبع نوری مختلف توی یه صحنه رو جداگانه رمزگذاری کنن. یعنی حتی اگه یه هکر زرنگ رمز یکی از نورها رو هم پیدا کنه، باید برای همه نورها جدا جدا تقلب کنه، و همه هم باید با هم هماهنگ باشن! اونم توی فیلم تقلبی واقعاً سختتر و تقریباً نشدنی میشه.

تستها نشون داده این روش توی شرایط فضای باز و روی آدمهایی با رنگ پوست مختلف هم جواب میده. ولی Davis میگه این یه چالش واقعاً ادامهدارهست و کلا مشکل دیپفیکها قراره هر روز سختتر هم بشه.

خلاصه اگر اهل شبکههای اجتماعی و دنبال کردن خبرها هستی، از این به بعد باید حواست خیلی بیشتر جمع باشه—و شاید یه روزی همین واترمارکهای نامرئی با نور به دادمون برسن تا فرق «واقعی» ویدیو با فیکها رو بفهمیم!

منبع: +