محققان چینی از LLaVA-o1، یک مدل بینایی-زبانی (VLM) متنباز، رونمایی کردهاند. این مدل با رویکردی ساختاریافته و چندمرحلهای، برای رقابت با مدل o1 شرکت OpenAI و بهبود تواناییهای استدلال بصری طراحی شده است. LLaVA-o1 با استفاده از مقیاسپذیری در زمان استنتاج و یک «جستجوی پرتو سطح-مرحلهای» جدید، عملکرد خود را در وظایف استدلال بصری پیچیده بهبود میبخشد.

مدل o1 شرکت OpenAI، پتانسیل مقیاسپذیری در زمان استنتاج – استفاده از قدرت محاسباتی بیشتر در طول استنتاج – را برای افزایش قابل توجه تواناییهای استدلال یک مدل زبانی نشان داد. این امر جرقه توسعه LLaVA-o1، یک مدل بینایی-زبانی (VLM) متنباز ایجاد شده توسط محققانی از دانشگاههای مختلف چین، را زد که هدف آن آوردن این الگو به VLMهای متنباز و به چالش کشیدن تسلط OpenAI در مدلهای استدلال پیشرفته است.

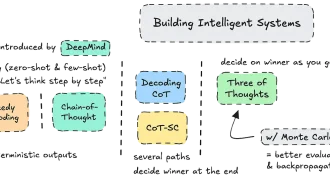

VLMهای متنباز اولیه اغلب به پیشبینی مستقیم متکی هستند و پاسخها را بدون فرآیند استدلال ساختاریافته تولید میکنند. این امر اثربخشی آنها را در وظایفی که نیاز به استنتاج منطقی دارند، محدود میکند. در حالی که تکنیکهایی مانند اعلان زنجیره-فکر (CoT) پیشرفتهایی را ارائه میدهند، مستعد خطا و توهم هستند. محققان یک مسئله اساسی را شناسایی کردند: فقدان یک فرآیند استدلال سیستماتیک و ساختاریافته در VLMهای موجود. این مدلها اغلب در حفظ یک زنجیره استدلال منسجم مشکل دارند که منجر به نتیجهگیری و توجیهات ناقص میشود.

با الهام از o1 شرکت OpenAI، LLaVA-o1 یک رویکرد استدلال چندمرحلهای را در بر میگیرد. به جای یک زنجیره استدلال مستقیم، فرآیند را به چهار مرحله مجزا تقسیم میکند:

- خلاصهسازی: مدل، مسئله اصلی مطرح شده در سوال را خلاصه میکند.

- عنوان: اگر تصویری درگیر باشد، مدل عناصر مرتبط با سوال را توصیف میکند.

- استدلال: بر اساس خلاصه، مدل استدلال منطقی ساختاریافتهای را برای رسیدن به یک پاسخ اولیه انجام میدهد.

- نتیجهگیری: مدل یک پاسخ مختصر مشتق شده از فرآیند استدلال ارائه میدهد.

فقط نتیجهگیری برای کاربر قابل مشاهده است. مراحل دیگر نشان دهنده استدلال داخلی مدل هستند، مشابه ردیابی استدلال پنهان o1. این رویکرد ساختاریافته به LLaVA-o1 اجازه میدهد تا فرآیند استدلال خود را به طور موثرتری مدیریت کند و عملکرد را در وظایف پیچیده بهبود بخشد.

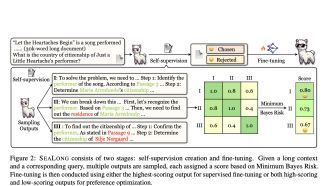

علاوه بر این، LLaVA-o1 یک تکنیک مقیاسپذیری در زمان استنتاج جدید به نام «جستجوی پرتو سطح-مرحلهای» را معرفی میکند. این تکنیک در هر مرحله استدلال چندین خروجی کاندید تولید میکند و بهترین کاندید را برای رفتن به مرحله بعدی انتخاب میکند. این با رویکرد سنتی بهترین-از-N متفاوت است، جایی که چندین پاسخ کامل قبل از انتخاب تولید میشوند. خروجی ساختاریافته LLaVA-o1، جستجوی پرتو سطح-مرحلهای را امکانپذیر میکند و امکان تأیید کارآمد و دقیق در هر مرحله را فراهم میکند.

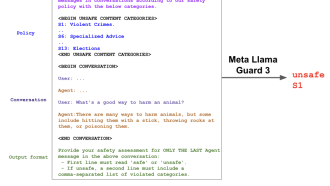

برای آموزش LLaVA-o1، محققان یک مجموعه داده جدید از تقریباً ۱۰۰۰۰۰ جفت تصویر-سوال-پاسخ از مجموعه دادههای مختلف VQA ایجاد کردند. این مجموعه داده طیف وسیعی از وظایف، از جمله پرسش و پاسخ چند نوبتی، تفسیر نمودار و استدلال هندسی را پوشش میدهد. GPT-4o برای تولید فرآیندهای استدلال چهار مرحلهای دقیق برای هر مثال به کار گرفته شد. سپس محققان Llama-3.2-11B-Vision-Instruct را بر روی این مجموعه داده تنظیم دقیق کردند تا مدل نهایی LLaVA-o1 را ایجاد کنند. در حالی که خود مدل هنوز منتشر نشده است، محققان قصد دارند مجموعه داده ۱۰۰۰۰۰ مثالی را با نام LLaVA-o1-100k منتشر کنند.

ارزیابیهای LLaVA-o1 در معیارهای مختلف استدلال چندوجهی، پیشرفتهای عملکرد قابل توجهی را نسبت به مدل پایه Llama نشان داد، با میانگین افزایش امتیاز معیار ۶.۹٪، با وجود اینکه فقط بر روی ۱۰۰۰۰۰ مثال آموزش داده شده است. جستجوی پرتو سطح-مرحلهای عملکرد را بیشتر افزایش داد و اثربخشی مقیاسپذیری در زمان استنتاج را نشان داد. محققان با محدودیت منابع محاسباتی، این تکنیک را با اندازه پرتو ۲ آزمایش کردند و پیشبینی میکنند که با اندازههای پرتو بزرگتر، پیشرفتهای بیشتری حاصل شود.

به طور قابل توجهی، LLaVA-o1 نه تنها از سایر مدلهای متنباز با اندازه مشابه یا بزرگتر، بلکه از برخی مدلهای منبع بسته مانند GPT-4-o-mini و Gemini 1.5 Pro نیز بهتر عمل کرد. این دستاورد استاندارد جدیدی را برای استدلال چندوجهی در VLMها تعیین میکند و عملکرد و مقیاسپذیری قوی، به ویژه در زمان استنتاج، ارائه میدهد.

توسعه LLaVA-o1 راههای جدیدی را برای تحقیق در استدلال ساختاریافته در VLMها باز میکند. تحقیقات آینده میتواند ادغام تأییدکنندههای خارجی و استفاده از یادگیری تقویتی را برای افزایش بیشتر قابلیتهای استدلال چندوجهی پیچیده بررسی کند. این کار گامی significant به سوی VLMهای متنباز قدرتمندتر و در دسترستر است که به طور بالقوه تسلط مدلهای منبع بسته را در زمینه استدلال بصری پیشرفته به چالش میکشد. انتظار میرود انتشار مجموعه داده LLaVA-o1-100k نیز به طور قابل توجهی در توسعه و معیارسنجی VLMهای متنباز آینده کمک کند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: venturebeat