احتمالاً اسم نظریه بازیها رو شنیدی، همون روشی که معمولاً برای پیشبینی حرکت آدم بده و آدم خوب توی بازیها یا مثلا جنگهای سایبری استفاده میشه. توی دنیای امنیت سایبری، نظریه بازیها حسابی پرکاربرد بوده تا الان. حالا با اومدن مدلهای زبانی بزرگ یا همون LLMها (Large Language Models یعنی مدلهایی مثل ChatGPT که میتونن کلی متن تولید کنن و به سوالا جواب بدن)، بازی یه کم پیچیدهتر و البته جذابتر شده.

تو این تحقیق اومدن بررسی کردن که آیا میشه با استفاده از مدلهای زبانی بزرگ، همون سناریوهای کلاسیک نظریه بازیها رو در دنیای امنیت سایبری شبیهسازی کرد یا نه. یعنی مثلاً اگه تو نقش مهاجم یا مدافع به این مدلها وظیفه بدی، رفتارشون معقول درمیاد یا الکی قاطی میکنن؟

یه توضیح کوتاه درباره نظریه بازی: نظریه بازیها یعنی یه روش ریاضی که باهاش میشه فهمید اگه چند نفر (یا چندتا الگوریتم!) باهم سر یه موضوع رقابت یا همکاری کنن، هرکدوم چه تصمیمی میگیرن که خودشون سود کنن. مثلاً بازی معروف Prisoner’s Dilemma یا معضل زندانی، که توش دو نفر باید تصمیم بگیرن همکاری کنن یا به هم خیانت کنن.

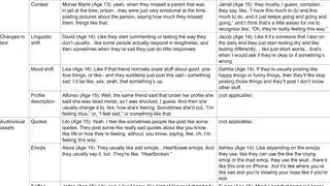

توی این تحقیق، دو بازی خیلی معروف رو با LLMها شبیهسازی کردن: یکی «بازی یکباره با سود صفر» (یعنی سود یکی ضرر اون یکیه، خلاصه پای کسی وسط نیست!) و اون یکی هم همون «معضل زندانی» که بالا گفتم. در اصل اومدن دیدن اگه وظیفهی شرکت تو این بازیها رو به مدلها بدن و بارها اجرا کنن، نتیجه میشه همونی که نظریه بازی پیشبینی میکنه یا نه. باحال اینه که این کار رو نه فقط به انگلیسی، بلکه چهارتا زبان زنده دیگه (فرانسوی، عربی، ویتنامی، چینی ماندارین) هم انجام دادن تا ببینن فرق داره یا نه.

نتایجشون خیلی جالب بوده! فهمیدن جوابای مدلها فقط به قوانین بازی بستگی نداره، بلکه کلی چیزای دیگه هم مؤثرن. مثلاً “شخصیت” مدل (بچه مثبت یا شر!) یا اینکه بدونه بازی چند بار تکرار میشه یا نه، رو نتیجه آخر خیلی تاثیر داره. یه چیز عجیبتر هم اینه که حتی زبانی که سوالا بهش پرسیده میشه هم نتیجه رو عوض میکنه! مثلاً ممکنه مدل تو انگلیسی یه رفتار نشون بده، تو عربی جور دیگهای بازی کنه! این یعنی اگه قراره از این مدلها تو امنیت سایبری جاهای مختلف دنیا استفاده بشه، نباید فکر کنیم رفتارشون همهجا یکسانه.

برای اینکه بتونن مقایسه کنند، یه سری معیارهای عددی (Quantitative metrics یعنی شاخصهایی که با عدد نشون میدن مدلها چقدر منطق خودشون رو حفظ کردن و تو زبانهای مختلف ثبات دارن) استفاده کردن. اینطوری میشه سنجید کدوم مدلها برای کار جدی و حساس مثلا دفاع سایبری به درد میخورن و کدوماشون ثبات ندارن و بهتره مراقب بود.

خلاصهی کلام: این تحقیق نشون داد هنوز جای کلی تحقیق مونده تا واقعا بفهمیم مدلهای زبانی بزرگ کجاها قابل اطمینانن و کجا ممکنه بیدلیل قاطی کنن، مخصوصاً تو حوزه حساس امنیت سایبری و تو زبانهای مختلف. پس اگه قراره از این مدلها استفاده کنیم، باید حواسمون باشه تو هر زبانی و شرایطی ممکنه یه جور خاص رفتار کنن — به همین خاطر به متخصصها توصیه شده که بیگدار به آب نزنن و مدل مناسب با توجه به ثبات و سازگاریشون انتخاب کنن.

منبع: +