بحث پیرامون اخلاق هوش مصنوعی و پیامدهای آن برای توسعهی هوش مصنوعی بسیار حیاتی است. چگونه میتوانیم اطمینان حاصل کنیم که هوش مصنوعی با ارزشهای انسانی همسو باشد و تصمیمات اخلاقی بگیرد؟ این مقاله به پیچیدگیهای اخلاق هوش مصنوعی و لزوم توسعهی مسئولانهی آن میپردازد.

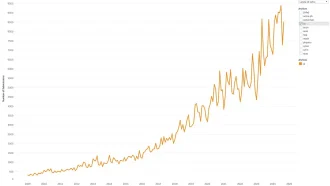

پیشرفت سریع هوش مصنوعی (AI)، به ویژه هوش مصنوعی مولد، امکانات هیجانانگیزی را به ارمغان آورده است، در حالی که همزمان پرسشهای اخلاقی پیچیدهای را مطرح میکند. با افزایش ادغام سیستمهای هوش مصنوعی در زندگی ما، بررسی چالشهای تطبیق رفتار ماشین با ارزشهای انسانی و نقش چارچوبهای اخلاقی در شکلدهی به توسعه مسئولانه هوش مصنوعی بسیار مهم است. مقررات اخیر، مانند قانون هوش مصنوعی اتحادیه اروپا و ابتکارات کاخ سفید ایالات متحده، بر نگرانی جهانی فزاینده برای شیوههای اخلاقی هوش مصنوعی تأکید میکنند. این مقاله مفاهیم اصلی اخلاق ماشین، چالشهای اجرای آن و مسیر پیش رو در پیمایش این چشمانداز پیچیده را بررسی میکند.

درک اخلاق ماشین

اخلاق ماشین، حوزهای که کاملاً جدید نیست، چگونگی برنامهریزی ماشینها برای تصمیمگیریهای اخلاقی و رفتار مسئولانه نسبت به انسانها و سایر ماشینها را بررسی میکند. این امر سؤالات اساسی در مورد آگاهی ماشین و ظرفیت آنها برای استدلال اخلاقی را مطرح میکند. آیا ماشینها واقعاً میتوانند قطبنمای اخلاقی مشابه انسان داشته باشند؟ حتی قبل از انتظار از ماشینها برای نشان دادن رفتار اخلاقی، لازم است ناسازاریها و سوگیریهای موجود در تصمیمگیری اخلاقی انسان را تصدیق کنیم. آیا خود انسانها در مواجهه با معضلات اخلاقی پاسخ ثابتی دارند؟ این خطاپذیری ذاتی انسان، وظیفه برنامهریزی رفتار اخلاقی در ماشینها را پیچیده میکند.

ماشینها از دادهها یاد میگیرند: چالش سوگیری

اساس یادگیری ماشین داده است. سیستمهای هوش مصنوعی، از جمله آنهایی که برای تصمیمگیریهای اخلاقی طراحی شدهاند، از مجموعه دادههای عظیم تعاملات، تصمیمات و رفتارهای انسانی یاد میگیرند. این امر سؤالات مهمی در مورد خود دادهها ایجاد میکند. چگونه میتوانیم اطمینان حاصل کنیم که دادههای مورد استفاده برای آموزش این سیستمها به طور دقیق اصول اخلاقی را منعکس میکنند؟ آیا اخلاق یک مفهوم جهانی است یا بر اساس دیدگاههای فرهنگی، اجتماعی و فردی متفاوت است؟ واقعیت این است که دادههایی که ما به الگوریتمها میدهیم اغلب منعکسکننده دیدگاههای ناسازگار و گاهی اوقات مغرضانه انسانهای درگیر است. این میتواند منجر به یادگیری سیستمهای هوش مصنوعی از تفسیر ناقص و بالقوه تحریفشده از اخلاق شود.

معضل اخلاقی کلاسیک یک وسیله نقلیه خودران را در نظر بگیرید که با یک تصادف اجتنابناپذیر روبرو است. آیا باید ایمنی سرنشینان خود را در اولویت قرار دهد یا جان گروهی از عابران پیاده را؟ اگر انتخاب بین کودک و یک فرد مسن باشد چه؟ این سناریوها پیچیدگیهای تصمیمگیری اخلاقی و فقدان یک رویکرد واحد و مورد قبول جهانی را برجسته میکنند. علاوه بر این، اغلب قضاوت عینی در مورد پیامدهای اخلاقی یک عمل، حتی برای انسانها، دشوار است.

Delphi: مطالعه موردی در اخلاق ماشین

Delphi، یک ربات گفتگو که توسط مؤسسه هوش مصنوعی آلن توسعه یافته است، یک مطالعه موردی قانعکننده در مورد چالشهای اخلاق ماشین ارائه میدهد. Delphi که برای تشخیص درست از نادرست طراحی شده است، قابلیتهای امیدوارکننده و محدودیتهای قابل توجهی را نشان داد. در حالی که میتوانست تقلب در امتحان را به درستی به عنوان نادرست تشخیص دهد، پاسخ آن در هنگام ارائه توجیه نجات جان برای تقلب، ظریفتر شد. با این حال، Delphi در مواجهه با پرسشهای پیچیده مربوط به سیاست و سایر موضوعات حساس، برای ارائه پاسخهای سازگار و اخلاقی با مشکل مواجه شد. این امر دشواری برنامهریزی ماشینها برای پیمایش پیچیدگیهای اخلاق انسانی را برجسته میکند.

ماشینها باید از چه ارزشها و اصولی پیروی کنند؟

سوال اصلی در اخلاق ماشین باقی میماند: ماشینها باید از چه ارزشها و اصولی پیروی کنند؟ همانطور که نوربرت وینر، ریاضیدان مشهور، به درستی گفته است، “بهتر است کاملاً مطمئن باشیم که هدفی که در ماشین قرار داده میشود، هدفی است که واقعاً میخواهیم.” قبل از انتظار از ماشینها برای هماهنگی اخلاقی با انسانها، ابتدا باید به درجه بالاتری از هماهنگی بین خودمان دست پیدا کنیم. این امر مستلزم تلاش هماهنگ برای تعریف و کمیسازی اصول اخلاقی به روشی است که مورد قبول جهانی باشد و بتوان آن را به طور مؤثر به کد تبدیل کرد. تشکیل یک کارگروه متنوع که نماینده طیف وسیعی از دیدگاههای اخلاقی باشد میتواند گام مهمی در این مسیر باشد.

راه پیش رو: شفافیت، پاسخگویی و چارچوبهای جهانی

آینده هوش ماشین نویدبخش است، اما باید اذعان کنیم که این سیستمها فقط به اندازه دادههایی که با آنها آموزش دیدهاند خوب هستند. دادههای مغرضانه یا کمنمایش به ناچار منجر به نتایج نادرست میشوند. تضمین دادههای آموزشی متنوع برای گنجاندن ملاحظات اخلاقی در سیستمهای هوش مصنوعی ضروری است. علاوه بر این، سازمانهایی که هوش مصنوعی را توسعه و مستقر میکنند باید شفافیت و پاسخگویی را در اولویت قرار دهند و چارچوبهای اخلاقی و فرآیندهای تصمیمگیری خود را به طور آشکار به اشتراک بگذارند. انتظار از توسعهدهندگان برای استنباط اصول اخلاقی بدون دستورالعملهای روشن غیرواقعی و بالقوه خطرناک است. ایجاد چارچوبهای سازمانی و جهانی قوی برای تعیین استانداردهای طلایی برای استفاده اخلاقی از هوش مصنوعی بسیار مهم است. در نهایت، ایجاد آگاهی گسترده و حساس کردن همه ذینفعان، چه در داخل و چه در خارج از تیمهای توسعه هوش مصنوعی، برای پرورش درک و همسویی جهانی در مورد شیوههای اخلاقی هوش مصنوعی ضروری است.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: kdnuggets