خب بچهها، امروز میخوام یه موضوع خیلی جالب رو باهاتون درمیون بذارم که جدیداً خیلی سر و صدا کرده: یه رویکرد خفن به اسم «مدآلمایتی» (MedAlmighty) که میخواد تشخیص بیماریها رو کلی بهتر کنه! بیاید با هم ببینیم داستان چیه.

اول از همه بگم، تشخیص درست بیماری واقعا مهمه، اما چالشهای خودش رو هم داره. چون دادههای پزشکی معمولاً هم تعدادشون کمه، هم خیلی جورواجورن (یعنی هر بیمار یه جور خاصیه و دادههاش فرق میکنه)، و همین باعث میشه که کار مدلهای هوش مصنوعی سختتر بشه.

حالا یه معادله جالب اینجاست: مدلهایی که سبک و جمع و جورن، سریعتر و کمخرجترن اما قدرت تشخیصشون معمولاً محدودتره و نمیتونن همه چیز رو درست بفهمن. از اون طرف، مدلهای بزرگ تصویری (مثل Large Vision Models) که با کلی داده عمومی آموزش دیدن، تو کار کلی خیلی خوبن اما خوب همه چیزِ پزشکی رو بلد نیستن! چون تو حوزه پزشکی داده کمه و فرق داره با دادههایی که این مدلها دیدن. اصلاً به این مشکل میگن Domain Gap یا همان فاصله بین حوزههای مختلف، یعنی چیزی که تو یه محیط جواب میده، شاید تو یه محیط دیگه جواب نده.

اینجا همونه که MedAlmighty وارد میشه. دانشمندها فهمیدن که اگه بتونیم هوش مدلهای بزرگ رو به مدلهای جمع و جورتر منتقل کنیم (که بهش میگن Knowledge Distillation، یعنی تقطیر دانش)، میشه هم از قدرت مدلهای بزرگ استفاده کرد و هم سرعت و سبک بودن کوچولوها رو داشت.

حالا دقیقاً چه اتفاقی میافته؟ اونا اومدن از یه مدل تصویری خیلی قوی به اسم DINOv2 (که قبلش با کلی عکس عمومی آموزش دیده) استفاده کردن، ولی فقط به عنوان راهنما یا به قول خودشون “teacher”. این مدل بزرگ یخزدهس! یعنی دیگه خودش آموزش نمیبینه و فقط نقش معلم رو داره. در کنارش، یه شبکه عصبی سبکتر (CNN یعنی شبکه عصبی کانولوشنی که مخصوص کارهای تصویریه) قرار داده شده که میخواد یاد بگیره. این یکی بهش میگن “student”. دانشآموز ما هم از دادههای اصلی یاد میگیره (hard labels یا برچسبهای سفت و سخت که همون جواب درست هستن) و هم از جوابای نرم و راهنماییهای معلم بزرگش (soft targets یعنی همون چیزی که مدل بزرگ پیشبینی میکنه—even اگه صددرصد مطمئن نباشه). در واقع، مدل کوچیکه حسابی از اطلاعات و تجربه معلم استفاده میکنه تا تیزهوشتر شه!

برای اینکه آموزش حسابی کامل شه، یه رویکرد آموزشی ترکیبی گذاشتن: هم باید جواب درست (Classification Accuracy) رو بشناسه، هم شباهت جوابش به معلمش (که بهش میگن Kullback-Leibler Divergence، یه معیار آماری واسه سنجیدن تفاوت بین دو توزیع). اینجوری مدل جمع و جور ما هم سریع و بهدردبخور میمونه و هم مفاهیم عمیق رو بهتر درک میکنه.

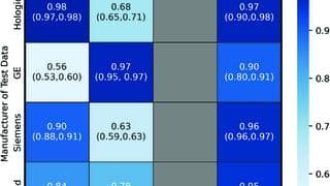

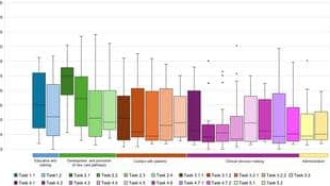

نتیجه چطور بود؟ تو آزمایشها دیدن که MedAlmighty واقعاً تو تشخیص بیماری اونم بین دادههای سخت و کم، ترکونده! یعنی بهتر از مدلهای قدیمی و پایهای کار کرد. هم دقتش بالا رفت و هم مقاومتش در برابر شرایط پیچیده بیشتر شد. خلاصه، تونستن هم از قدرت مدلهای بزرگ استفاده کنن و هم دقت و تخصص مدلهای کوچیک رو بالا ببرن.

در کل مقاله گفت که این ایده، یعنی استفاده از مدلهای غولپیکر (اما یخزده و ثابت) در کنار مدلهای سریعتر، اگه با استراتژی تقطیر درست ترکیب شه، میتونه ضعف کمبود داده و تفاوت حوزهها رو تو پزشکی جبران کنه. نویسندهها گفتن که میشه این روش رو تو زمینههای دیگه پزشکی هم امتحان کرد یا حتی اطلاعات چندتا نوع داده مختلف رو با هم ترکیب کرد (مثلاً عکس و متن پزشکی رو با هم بر هم منطبق کنن، که بهش میگن MultiModal Alignment).

در نهایت خلاصهش اینه که اگه تا حالا فکر میکردین مدلهای سبک نمیتونن با مدلهای بزرگ رقابت کنن، MedAlmighty نشون داد اگر تیموار کارکنن، کلی کار ازشون برمیاد! 😉

منبع: +