خب دوست من، بیا یکم درباره اینکه چطور هوش مصنوعیها میتونن از ساده بودن در بیان و کمکم به یه سوپرهوش تبدیل شن با هم گپ بزنیم! مخصوصاً وقتی بحث «استدلال» و راه حل پیدا کردن برای مسائل سخت پیش میاد. یه چیز جذاب این روزها توی دنیای هوش مصنوعی اومده که بهش میگن Chain-of-Thought یا به اختصار CoT. این یعنی هوش مصنوعیها به جای اینکه یه جواب سریع بدن، قدم به قدم فکر میکنن و استدلال خودشون رو نشون میدن، درست مثل زمانی که خودمون حل یه مسئله ریاضی رو روی کاغذ مینویسیم.

حالا، کلی مدل و روش هست که سعی میکنن به هوش مصنوعیها یاد بدن چطور بهتر استدلال کنن. چیزهایی مثل «Supervised Fine-Tuning (SFT)»، یعنی آموزش با دادههای برچسبدار، «Reinforcement Learning (RL)» که همون یادگیری تقویتی خودمونه و مدلهایی مثل Tree-of-Thoughts (ToT) که میاد مراحل فکر کردن رو مثل درخت رسم میکنه و یا Monte Carlo Tree Search (MCTS) که یه جور جستجو برای پیدا کردن بهترین مسیر حل مسئلهست. فقط مشکل اینجاست که وقتی مسئلهها پیچیده و سخت میشن، این روشها اغلب کم میارن و نمیتونن درست و حسابی از CoT استفاده کنن.

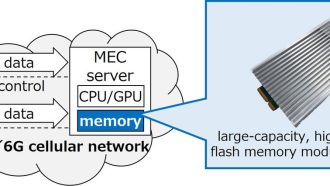

چرا این اتفاق میافته؟ خب، توی این مقاله اومدن سه تا دلیل اصلی پیدا کردن: اولیش distribution drift یا به زبون ساده، تغییر تو الگوهای داده در طول زمانه، که باعث میشه مدلی که آموزش دیدی تو شرایط جدید خوب کار نکنه. دومین مشکل، نبود جستجو به صورت داخلی یا embedded search هست؛ یعنی مدل فقط میگه جواب چی میشه، ولی خودش عملاً نمیره دنبال راه حلهای مختلف بگرده. سومی هم میرسه به exponential inference cost یا هزینه محاسباتی خیلی زیاد موقع استنتاج که وقتی عمق فکر کردن زیاد بشه، منابع زیادی میطلبه و عملاً اجرایی نیست.

حالا خبر خوب: کلی مقاله جدید درباره یه ایده باحال به اسم Diligent Learner یا «یادگیرنده پرتلاش» منتشر شده. این مدل، برعکس بقیه، حل مسئله رو مثل یه جستجوی عمقی (depth-first search) مدل میکنه. جستجوی عمقی یعنی مثل وقتی که توی یه مسیر میری جلو، اگر اشتباه کردی، برمیگردی و راه جدید رو امتحان میکنی؛ یعنی همون backtracking یا برگشت به عقب موقع شکست خوردن. تازه یه چیزی هم بهش اضافه کردن به اسم validator یا اعتبارسنج که به مدل کمک میکنه بفهمه جوابش منطقی هست یا نه.

نکته جذاب دیگه اینه که دانشمندها اومدن براش دو تا فرض خیلی معمولی و واقعی در نظر گرفتن و نشون دادن که بر خلاف روشهای قدیمی، این یادگیرنده پرتلاش واقعاً میتونه با دادههای CoT (که معمولاً ناقص و طبیعی هستن) کلی چیز یاد بگیره! یعنی اگه بخوایم با دادههای ناکامل و پراکنده، هوش مصنوعیمون رو به یه مدل پرقدرت و قابل تفسیر تبدیل کنیم، این روش واقعاً جواب میده.

در آخر، این مقاله نشون میده با این روش Diligent Learner میتونیم راه رو برای ساخت Large Reasoning Models یا همون LRMها هموار کنیم. LRMها یعنی هوش مصنوعیهایی که واقعاً استدلال رو بلد باشن، قابل اعتماد باشن و بتونیم برای حل مسئلههای سخت حساب ویژهای رویشون باز کنیم.

خلاصهش اینه که با ایده «یادگیرنده پرتلاش»، مسیری برای آموزش هوش مصنوعیها باز شده که وعده مدلهایی رو میده که هم مقیاسپذیرن، هم قابل اطمینان و هم میشه توضیح داد واقعاً چطور به جواب رسیدن. حالا میتونیم امیدوار باشیم هوش مصنوعیها قراره واقعاً فکر کردن رو یاد بگیرن، نه فقط حفظ کردن اطلاعات رو!

منبع: +