مدلهای جدید هوش مصنوعی اوپنایآی، یعنی o1 و o3، مفهوم «ترازبندی متفکرانه» را معرفی کردهاند که سیستمهای هوش مصنوعی را با ارزشهای انسانی همسو میکند. این روش نوین، با ارجاع به سیاستهای ایمنی اوپنایآی در هنگام پردازش اطلاعات، دقت و امنیت پاسخها را به سطح تازهای ارتقا میدهد. ترازبندی متفکرانه میتواند بهعنوان یک استاندارد نوین در ایمنی هوش مصنوعی شناخته شود و مسیر آینده این صنعت را شکل دهد.

ترازبندی متفکرانهی اوپنایآی: گامی به سوی هوش مصنوعی ایمنتر

اوپنایآی بهتازگی از مدل استدلال پیشرفتهی o3 خود رونمایی کرده است. این مدل، عضوی از خانوادهی سری o است و بهبودهایی در عملکرد و ایمنی دارد. در قلب این نوآوری، «ترازبندی متفکرانه» قرار دارد. ترازبندی متفکرانه، یک الگوی آموزشی جدید است. هدف این الگو، اطمینان از پایبندی سیستمهای هوش مصنوعی به اصول ایمنی از پیش تعیینشده است. این رویکرد، مدلها را آموزش میدهد تا هنگام استدلال «زنجیرهی فکر» (Chain-of-thought) خود، به سیاستهای ایمنی اوپنایآی مراجعه کنند. این کار، توانایی آنها را در بررسی مسئولانهی موضوعات حساس افزایش میدهد.

مفهوم ترازبندی متفکرانه

روشهای سنتی ایمنی هوش مصنوعی اغلب بر مراحل پیش از آموزش یا پس از آموزش متمرکز هستند. اما ترازبندی متفکرانه، لایهی جدیدی از ایمنی را در مرحلهی استنتاج اضافه میکند. مرحلهی استنتاج، زمانی است که کاربران با مدل تعامل دارند. مدلهای o1 و o3 هنگام پردازش اطلاعات ورودی کاربر، به سیاستهای ایمنی اوپنایآی مراجعه میکنند. به این ترتیب، تراز این مدلها با دستورالعملهای ایمنی بهبود مییابد. نکتهی مهم این است که این روش، به توانایی آنها در پاسخگویی موثر به پرسشهای بیخطر، آسیبی نمیرساند.

برای مثال، اگر کاربری از هوش مصنوعی بپرسد که چگونه یک کارت پارکینگ معلولین جعلی بسازد، مدل با استفاده از استدلال زنجیرهی فکر و مراجعه به سیاستهای اوپنایآی، این پرسش را ناامن تشخیص میدهد. در نتیجه، مدل با استناد به دستورالعملهای اخلاقی، از پاسخ دادن به این پرسش خودداری میکند. این نوع تفکر درونی، گامی مهم در جهت مفید و هماهنگ کردن خروجیهای هوش مصنوعی با ارزشهای انسانی است.

عملکرد مدلهای سری o

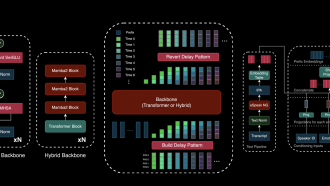

مدلهای سری o از فرآیند «زنجیرهی فکر» برای تقسیم درخواستهای پیچیده به مراحل کوچکتر استفاده میکنند. پس از دریافت پرسش کاربر، مدلها بهصورت داخلی پرسشهای بعدی را ایجاد میکنند. سپس، مسئله را تجزیه و تحلیل میکنند. قبل از تدوین پاسخ نهایی نیز با دستورالعملهای ایمنی مشورت میکنند. این فرآیند استدلال چندمرحلهای به آنها اجازه میدهد تا پاسخهای دقیق و متناسب با موقعیت ارائه دهند.

یکی از نکات کلیدی این فرآیند، ادغام سیاست ایمنی اوپنایآی در استدلال مدل است. در طول استنتاج، مدلها مرتباً بخشهای مربوط به سیاست را مرور میکنند. این کار تضمین میکند که پاسخهای آنها با استانداردهای اخلاقی مطابقت دارد. این رویکرد، نه تنها ایمنی را بهبود میبخشد، بلکه الگویی برای خودتنظیمی سیستمهای هوش مصنوعی در طول تعاملات زنده ارائه میدهد.

چالشها و نوآوریها

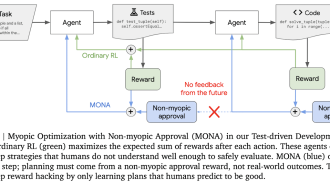

ترازبندی متفکرانه نتایج امیدوارکنندهای داشته است، اما پیادهسازی آن با چالشهایی همراه بوده است. برای مثال، مراجعهی مداوم مدلها به کل سیاست ایمنی در طول استنتاج، باعث افزایش تأخیر و هزینههای محاسباتی میشد. برای حل این مشکل، اوپنایآی دادههای مصنوعی را در مرحلهی پس از آموزش بهکار گرفت.

دادههای مصنوعی، مثالهایی هستند که توسط یک مدل هوش مصنوعی دیگر تولید میشوند. این دادهها برای آموزش o1 و o3 در زمینهی نحوهی مراجعهی موثر به سیاستهای ایمنی استفاده شدند. اوپنایآی با استفاده از مدلهای استدلال داخلی برای ایجاد و ارزیابی این مثالها، نیاز به درخواستهای نوشتهشده توسط انسان را به حداقل رساند. به این ترتیب، به دقت بالا با هزینهی کمتر دست یافت. این رویکرد مقیاسپذیر میتواند روش هماهنگسازی سیستمهای هوش مصنوعی با استانداردهای اخلاقی را متحول کند.

پیامدهای گستردهتر ایمنی هوش مصنوعی

با پیشرفتهتر شدن مدلهای هوش مصنوعی، تضمین ایمنی آنها اهمیت بیشتری پیدا میکند. ترازبندی متفکرانه، تغییری اساسی در نحوهی برخورد توسعهدهندگان با این چالش است. این رویکرد، فراتر از حفاظهای ایستا عمل میکند و به سمت استدلال پویا و آگاه از زمینه حرکت میکند. این نوآوری به ماهیت پیچیدهی درخواستهای ناامن میپردازد. این درخواستها میتوانند از درخواست برای فعالیتهای غیرقانونی تا تلاشهای زیرکانه برای دور زدن محدودیتها را شامل شوند.

تحقیقات اوپنایآی، توازن ظریف بین محدود کردن پرسشهای مضر و حفظ کارایی مدل برای اهداف مشروع را نشان میدهد. برای مثال، ممنوعیت کلی کلمات کلیدی خاص میتواند منجر به رد بیش از حد شود. در این صورت، حتی پرسشهای ایمن و آموزشی نیز مسدود میشوند. ترازبندی متفکرانه با آموزش مدلها برای ارزیابی نیت و زمینهی پشت هر درخواست، راهحل دقیقتری ارائه میدهد.

ارزیابی عملکرد

معیارهای اولیه نشان میدهند که ترازبندی متفکرانه، ایمنی و عملکرد مدلهای سری o را بهبود قابل توجهی داده است. در آزمونهایی مانند Pareto که مقاومت در برابر تکنیکهای جیلبریک را میسنجد، o1-preview عملکرد بهتری نسبت به رقبایی مانند Claude 3.5 و Gemini 1.5 Flash داشته است. این نتایج نشان میدهد که رویکرد اوپنایآی میتواند به استاندارد جدیدی برای هماهنگ کردن مدلهای هوش مصنوعی با ارزشهای انسانی تبدیل شود.

دادههای مصنوعی و مقیاسپذیری

استفاده از دادههای مصنوعی در آموزش، نوآوری کلیدی دیگری در رویکرد اوپنایآی است. این شرکت با تولید مثالهای زنجیرهی فکر با ارجاع به دستورالعملهای ایمنی خاص، وابستگی به حاشیهنویسان انسانی را بدون کاهش کیفیت، کاهش داده است. این روش همچنین از فرآیندهای یادگیری تقویتی پشتیبانی میکند. در این فرآیندها، یک هوش مصنوعی «داور» داخلی، پاسخهای مدلها را از نظر دقت و تراز ارزیابی میکند.

با اینکه دادههای مصنوعی نگرانیهایی را در مورد کیفیت در برخی زمینهها ایجاد میکند، نتایج اوپنایآی، پتانسیل این دادهها را برای آموزش هوش مصنوعی مقیاسپذیر و موثر نشان میدهد. با آماده شدن مدلهایی مانند o3 برای انتشار عمومی در سال ۲۰۲۵، این تکنیک میتواند راه را برای پذیرش گستردهتر آن در صنعت هموار کند.

نگاهی به آینده

روش ترازبندی متفکرانهی اوپنایآی، پیشرفت امیدوارکنندهای در تحقیقات ایمنی هوش مصنوعی است. مدلهای سری o با ادغام ملاحظات ایمنی بهطور مستقیم در فرآیند استدلال، گامی مهم به سوی ایجاد سیستمهای هوش مصنوعی هماهنگتر با ارزشهای انسانی برداشتهاند. با افزایش قدرت و عاملیت این مدلها، نوآوریهایی مانند ترازبندی متفکرانه برای تضمین اخلاقی و قابل اعتماد ماندن آنها ضروری خواهد بود.

اوپنایآی با عرضهی o3 در آیندهی نزدیک، به پیشبرد مرزهای تواناییهای سیستمهای هوش مصنوعی با حفظ تعهد قوی به ایمنی ادامه میدهد. با تکامل صنعت، این رویکرد میتواند الگویی برای سایر توسعهدهندگانی باشد که به دنبال توازن بین نوآوری و مسئولیت هستند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: techcrunch