یه خبر داغ و جالب درباره دنیای هوش مصنوعی اومده که میخوام امروز باهاتون رفیقطور در موردش حرف بزنم. حتماً اسم سامسونگ، Sandisk و SK Hynix به گوشتون خورده، مخصوصاً اگه دستی تو تکنولوژی داشته باشین. حالا دو تا از این غولها یعنی Sandisk و SK Hynix اومدن با هم یه توافق همکاری امضا کردن که ممکنه روی عملکرد هوش مصنوعی (AI) کلی تاثیر بذاره.

موضوع از این قراره که این دوتا شرکت دارن تلاش میکنن یه استاندارد جدید به اسم “High Bandwidth Flash” یا همون HBF تعریف کنن. اگه براتون سواله که HBF یعنی چی، بذار راحت توضیح بدم: الان تو کارت گرافیکهایی که مخصوص هوش مصنوعی هستن، یه چیزی به اسم HBM یا همون “حافظه پرسرعت” استفاده میشه که معمولاً با DRAM ساخته میشه. DRAM همون حافظههاییه که اگه برقش قطع بشه، همه چی پاک میشه و ظرفیتشم یه حدیه؛ ولی از نظر سرعت خیلی سریعه.

اما Sandisk و SK Hynix میخوان همین ایده حافظه پرسرعت رو با NAND Flash ترکیب کنن. NAND Flash مثل همون حافظههایی هست که توی SSD و فلش مموری داریم. خوبی NAND اینه که وقتی برق قطع بشه، اطلاعات رو نگه میداره (یعنی non-volatile هست). اینطوری با حافظه HBF میشه یه حجمی خیلی خیلی بزرگتر (بین ۸ تا ۱۶ برابر ظرفیت DRAM-based HBM!) رو با هزینه تقریبا مشابه، در اختیار مدلهای هوش مصنوعی گذاشت.

حالا چرا این مهمه؟ چون مدلهای بزرگ هوش مصنوعی برای یادگیری و جواب دادن به سوالات نیاز به حجم زیادی دیتا دارن. با این روش، نه تنها ظرفیت ذخیرهسازی خیلی بالا میره، بلکه مصرف انرژی هم کمتر میشه. چون NAND Flash واسه نگه داشتن اطلاعات، دائم نیاز به برق نداره؛ برخلاف DRAM که اگه یک لحظه برق قطع بشه همه اطلاعات میپره.

این ایده خیلی با کارایی مراکز داده (Data Centers) سازگاره، مخصوصاً جاهایی که مصرف برق و خنککاری (خنک نگه داشتن تجهیزات) یه دغدغه جدیه. مثلاً Hyperscale Operators یعنی شرکتهایی که مراکز داده خیلی بزرگ و مدلهای پیشرفته دارن، احتمالاً براشون این حافظههای جدید هم صرفه اقتصادی داره و هم راحتتر میتونن با گرما و هزینههای بالا مبارزه کنن.

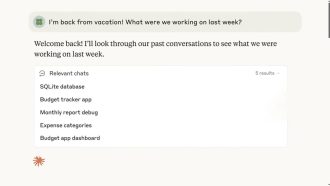

یه تحقیق هم بوده به اسم “LLM in a Flash” (LLM یعنی Large Language Model یا همون مدلهای زبانی بزرگ مثل ChatGPT) که توش گفته شده اگه SSDها به کمک DRAM بیان، میشه خیلی بهینهتر این مدلها رو اجرا کرد. الان ایده HBF دقیقاً همون منطق رو تو یه بستهبندی سریع و یکجا پیاده کرده! یعنی مثلاً هم سرعت نزدیک حافظههای پرسرعت رو داره، هم ظرفیت عظیم SSDها رو.

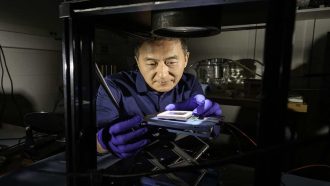

Sandisk تو نمایشگاه Flash Memory Summit 2025 اولین نمونه پروتوتایپ (مدل اولیه) این حافظه رو نشون داده. این نمونه با تکنولوژی اختصاصی BiCS NAND (یعنی یه روش ساخت خاص برای حافظه فلش) و تکنولوژی wafer bonding (یه جور چسبوندن لایههای مختلف سیلیکون بههم برای ساخت تراشههای پیچیده)، ساخته شده. گفته شده نمونههای اولیه این حافظه سال ۲۰۲۶ عرضه میشن و اولین کامپیوترهای هوش مصنوعی که از این تکنولوژی پشتیبانی کنن، اوایل ۲۰۲۷ میان رو خط تولید.

فعلاً خبر رسمی از اینکه کدوم شرکتها میخوان محصولات واقعی با این تکنولوژی بسازن نیومده، ولی چون SK Hynix یکی از بزرگترین تأمینکنندههای حافظه برای چیپهای AI، مثلاً برای Nvidia هست، پس احتمالاً وقتی استانداردهای فنی مشخص بشن، این قضیه خیلی سریع پخش میشه بین سازندهها.

جالب اینجاست که سامسونگ (رقیب بزرگ این پروژه) هم نشسته روی یه تکنولوژی مشابه کار میکنه، اونم داره روی حافظههای HBM4 و حافظههای فلش برای AI سرمایهگذاری میکنه. البته Nvidia فعلاً رو همون حافظههای DRAM سنگین تمرکز کرده، چون سرعت براش مهمتره، ولی اگه HBF جواب بده، میتونیم تصور کنیم تو آینده یه جا حافظه DRAM، و NAND Flash و حتی بقیه انواع حافظه کنار هم کار کنن و به کامپیوترها کمک کنن که کلی دیتا رو همزمان و سریع پردازش کنن.

در کل، اگه این پروژه جواب بده، میشه انتظار داشت تکنولوژی حافظه تو دنیای هوش مصنوعی یه حرکت اساسی به سمت صرفهجویی انرژی و افزایش ظرفیت برداره. یعنی شاید سرویسها و اپلیکیشنهایی که الان رویا بودن، با این حافظهها در آینده براشون ممکن بشه. به نظرتون، آینده چجوری میشه وقتی کامپیوترها میتونن همزمان انقدر داده زیاد رو با قیمت و انرژی کمتر نگهدارن و پردازش کنن؟

منبع: +