خب بذارین خیلی خودمونی براتون توضیح بدم. فکر کنین کلی آدم تو آمریکا هستن که آلزایمر گرفتن (همون بیماری که حافظه آدم رو نابود میکنه، مخصوصاً سن بالاها)، ولی باورتون نمیشه، بالای نصفشون خبر ندارن که این بیماری رو دارن! حالا یه سری دانشمند اومدن یه روش باحال پیدا کردن: گفتن اگه فقط با حرف زدن و صدای طرف بتونیم بفهمیم آلزایمر داره یا نه، دیگه نیاز نیست تستها و آزمایشهای سخت انجام بشه. اینجوری میشه خیلی راحت و سریع افراد بیشتری رو بررسی کرد.

اینجا هوش مصنوعی وارد داستان میشه! اگه نمیدونین، هوش مصنوعی یا همون AI یعنی سیستمهای کامپیوتری باهوشی که میتونن شبیه ما فکر کنن یا یاد بگیرن. حالا مدلهایی داریم به اسم «مدل زبون بزرگ» یا Large Language Model (LLM) که همون ChatGPT خودش نمونهشه – این مدلها کلی متن و حرف یاد گرفتن و میتونن معنی چیزهایی که میشنون یا میخونن رو بفهمن.

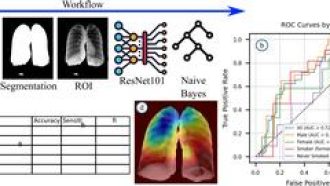

توی این تحقیق، اومدن چندتا مدل مختلف هوش مصنوعی رو با هم مقایسه کردن تا ببینن کدومش بهتر میتونه فقط از روی حرف زدن آدمها (با استفاده از مجموعه دادهای به اسم DementiaBank که کلی صدای حرف زدن بیمارانِ آلزایمری توش هست) تشخیص بده که کی آلزایمر داره کی نه. جالبش اینجاست که هم مدلهایی که فقط متن رو میخونن امتحان کردن و هم مدلهایی که هم صدا رو میگیرن، هم متن رو بررسی میکنن (اینا رو بهشون مدلهای “چندرسانهای” میگن، یعنی با ورودیهای مختلف کار میکنن).

حالا این وسط یه عالمه روش مختلف هم برای بهتر کردن مدلها امتحان کردن. مثلاً:

- یادگیری در بستر مثال: یعنی مدل موقع تصمیم گرفتن چندتا نمونه براش میذارن که شبیه به نمونه اصلی باشه.

- دموهای مرکز کلاسی (class-centroid demonstrations): یعنی به مدل نمونههایی میدن که دقیقا وسط همهی نمونههای مشابه اون بیماری هست – این روش بهترین نتیجه رو گرفت.

- دلیلآوری: با اضافه کردن دلایل برای کمک به مدلهای کوچیکتر باعث شدن بهتر بفهمن و تصمیم بگیرن. یعنی مثلاً توضیح دادن چرا فکر میکنیم فلانی آلزایمر داره.

- تنظیم پارامتری بهینه (parameter-efficient fine-tuning): یعنی فقط یسری بخشهای مدل رو تغییر میدن به جای اینکه همهشو دوباره آموزش بدن که سریعتر و راحتتره. بهش میگن ‘فاینتیونینگ’. تو این کار، فاینتیونینگ سطح نشونه (token-level) معمولاً بهترین نتیجهها رو داد.

- اضافه کردن بخش طبقهبندی (classification head): به مدلهایی که خوب جواب نمیدادن یه بخش جدا به اسم “هد طبقهبندی” وصل کردن که باعث شد بهتر بشن. این یعنی یه جور ماژول اضافه که آخر مدل خروجیش رو طبقهبندی میکنه.

از نظر مدلهای چندرسانهای (همزمان صدا و متن رو با هم کار میکنن)، اونایی که صدای افراد رو هم به مدل اضافه کردن و روشون فاینتیونینگ انجام دادن بد نبودن، اما با این حال، بهترین مدلهای فقط متنی همچنان بالاترن!

خلاصه اینکه هر کاری مربوط به انتخاب نمونه برای آموزش، نوع دلیل دادن یا حتی اینکه مدل رو چطور فاینتیون کنید رو مدل خیلی تاثیر میذاره و میتونه باعث بشه این مدلها حتی بهتر از مدلهای تجاری بزرگ (که پولی هستن!) عمل کنن. یعنی شما میتونین با مدلهای باز (open-weight models)، که رایگان یا قابل دسترسترن، نتیجههایی در حد بهترین مدلهای تجاری بگیرین.

در نهایت، این تحقیق نشون داد مدلهای زبان و صدا با یه سری تکنیک باحال واقعا میتونن کمک کنن خیلی راحتتر و سریعتر آلزایمر رو تشخیص بدیم – فقط کافیه طرف چند دقیقه حرف بزنه تا هوش مصنوعی بفهمه تو ذهنش چی میگذره! چقدر آیندهوار و ترسناک جالبه نه؟

منبع: +