اگه خودروی خودران و سیستمهایی مثل کمکراننده رو دوست داری، حتماً میدونی مدلهایی هستن که کارشون تشخیص خطوط خیابون (Lane Detection یا همون LD) روی جادهست. خب، این مدلها پایه و اساس خیلی از تکنولوژیهای رانندگی خودکار هستن. اما یه مشکل بزرگ دارن: آسیبپذیری در مقابل حملههایی به اسم backdoor attack یا مثلاً “خرابکاری بک دور”.

خب بک دور چیه؟ این حملهها جوری طراحی میشن که مدل هوش مصنوعی اگه یه علامت مخفی خاص (بهش میگیم trigger – یعنی همون نشونه مخفی) ببینه، قشنگ گول میخوره و اشتباه بزرگی مرتکب میشه! مشکل اینجاست که بیشتر تحقیقهای قبلی سراغ چیزایی رفتن که اون نشونه خیلی تابلو و غیرطبیعتی بود و خب توی دنیای واقعی راحت لو میرفتن.

حالا این مقاله اومده یک روش خفنتر و واقعیتر پیشنهاد بده: گفتن بیاید حملههایی درست کنیم که تو فضای واقعی و طبیعی لو نرن.

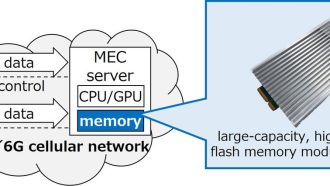

وایستا ببین دیگه چه کردن! اونا یک چارچوب (Framework) معرفی کردن به اسم DBALD (که خلاصه Diffusion-Based Attack on Lane Detection هست). این روش بر اساس data poisoning یعنی ‘آلودگی داده’ کار میکنه. یعنی اطلاعات ورودی مدل هوش مصنوعی رو یواشکی خراب میکنن و وقتی این مدل روند آموزشی خودش رو انجام میده، ضایع نمیفهمه که قراره با دیدن یه نشونه خاص، رفتار اشتباه در پیش بگیره.

DBALD دوتا بخش اصلی جالب داره:

- پیدا کردن بهترین جای ممکن برای قرار دادن نشونه مخفی. یعنی با یه روش گرادیان-محور (یعنی از روی شیب رفتارش تحلیل میکنن) یک نقشه درست میکنن (heatmap) که نشون میده کجاها مدل نسبت به خرابکاری حساستره.

- ساختن نشونههایی که واقعاً طبیعی و غیرقابل تشخیص باشن. یعنی با یک فرآیند پخش (diffusion process) میرن تو همون نقطههای حساس، خیلی حرفهای یک نشونه درست میکنن که به چشم هیچ رانندهای نیاد ولی مدل هوش مصنوعی دقیقاً با دیدنش بهم بریزه.

برای اینکه مدل لو نره یا نشونهها تابلو نشن، دوتا تکنیک اضافهتر هم گذاشتن:

- یکی اینکه فرم و ساختار خطوط جاده حفظ شه تا صحنه عادی به نظر بیاد.

- یکی دیگه هم اینکه ‘یکپارچگی صحنه رانندگی’ رو نگه دارن. یعنی حتی اگه یه جایی دستکاری میکنن، بقیه تصویر به هم نریزه!

حالا بیاید سراغ نتیجهها: وقتی این روش رو روی ۴ مدل معروف تشخیص خط تست کردن، فهمیدن DBALD واقعاً از روشهای قبلی بهتر کار میکنه. مثلاً موفقیتش تو خراب کردن مدلها به طور میانگین ۱۰.۸۷ درصد بیشتر بوده! (یعنی واقعاً عدد چشمگیریه) تازه در کنار این موفقیت، نشونههایی که تولید میکنه خیلی سختتر شناسایی میشن و احتمال لو رفتنشون پایینتره.

در کل این مقاله میخواد نشون بده که امنیت مدلهای هوش مصنوعی تو ماشینهای خودران و کمکراننده، خیلی راحتتر از چیزی که فکر میکردیم به خطر میافته! مخصوصاً اگه هکرها از روشهایی مثل DBALD استفاده کنن که نشونهها رو مثل یک قطعه طبیعی خیابون تو تصویر جا میزنن و مدل رو از کار میاندازن، بدون اینکه چشم انسان متوجه چیزی بشه.

پس اگه ماشین خودران دوست داری، بدون که این چالشها پشت صحنه حسابی مهم و جدیان و دانشمندها دارن به کلی راههای خلاقانه برای خرابکاری و البته راههای مقابله فکر میکنن!

منبع: +