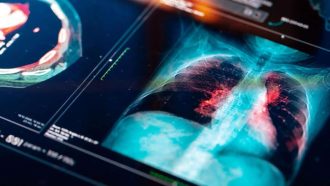

اگه تا حالا فکر میکردی همه داستانهای هوش مصنوعی (همون AI خودمون)، فقط درباره انگلیسیه، بهتره دوباره فکر کنی! این روزا دیگه مدلهای زبونگنده یا همون LLMها (Large Language Models یعنی مدلهایی که میتونن کلی متن و جمله بسازن و سوال جواب بدن) دارن وارد ماجراهای پزشکی تو کل دنیا میشن. ولی خب، یه مشکل اینجا هست: آیا واقعاً این مدلها بلدن با زبان و سیستم پزشکی کشورهای غیرانگلیسی مثل سوئد درست کار کنن یا نه؟

چندتا دانشمند تو سوئد یه پروژه توپ به اسم «SMLB» راه انداختن، که یعنی «سوئدی مدیکال الالام بنچمارک» (Swedish Medical LLM Benchmark)؛ بنچمارک هم یعنی یه چارچوب یا معیار برای سنجیدن و مقایسه. خلاصه اومدن یه قالب خاص برای تست کردن این مدلهای زبانی تو محیط پزشکی سوئد ساختن که واقعاً خیلی لازمه، چون تستهای پزشکی کلی حساس و تخصصیه و تازه به زبان سوئدی هم هست.

داستان SMLB اینطوریه که چهار نوع دیتاست باحاله رو برای سنجش مدلها استفاده میکنه:

- سوالهای PubMedQA (یه مجموعه سوال و جواب انگلیسی درباره پزشکی که ترنسلیت کردن به سوئدی)

- آزمونهای پزشکی مخصوص سوئد (یعنی همون امتحانهایی که دانشجوهای پزشکی سوئد میدن)

- سناریوهای اورژانس پزشکی (یعنی همون موقعیتی که قراره سریع تصمیم بگیری چی کار کنی!)

- کیسهای پزشکی عمومی (یعنی پروندههای معمول و عادی پزشکی)

همه اینها رو ریختن تو یه قالب تا مدلهای مختلف رو بسنجن و بفهمن کدوم مدل واقعاً به درد پزشکهای سوئدی میخوره.

حالا میخوای بدونی کدوم مدلها بهترین بودن؟ طبق این تحقیق روی ۱۸ تا از خفنترین مدلهای امروزی، سهتاشون کولاک کردن: GPT-4-turbo (همون هوش مصنوعی پیشرفته شرکت OpenAI)، مدل Claude-3.5 (نسخه اکتبر 2023، که مال Anthropic هست)، و یک مدل دیگه به اسم o3model. این سه تا نشون دادن که هم از نظر زبانی قویان و هم از نظر منطق و دلیل پزشکی، تقریباً چیزی کم ندارن.

یه چیز جالب دیگه اینه که اگه مدلها رو دوپینگ کنی با RAG، یعنی Retrieval-Augmented Generation (یه روشی که مدل اول میره اطلاعات رو از دیتابیس پیدا میکنه و بعد جواب میده)، دقت تو سوالای پزشکی بیشتر هم میشه! پس این سیستم ترکیبی واقعاً میتونه آینده استفاده از هوش مصنوعی تو بحث درمان بیماران رو امنتر و مطمئنتر کنه.

اما همه چیز هم گل و بلبل نیست؛ این تحقیق نشون داد عملکرد مدلها خیلی با هم فرق داره و هیچ تضمینی نیست که هر مدلی همه چیز رو درست جواب بده. واسه همین دانشمندا این بنچمارک رو کاملاً متنباز کردن (open-source یعنی هر کسی میتونه ازش استفاده کنه یا کاملترش کنه) تا همه توی مسیر توسعه هوش مصنوعی مسئولانه حرکت کنن.

جمعبندی کنم: اگه قرار باشه هوش مصنوعی بیاد تو بیمارستانها و کنار دکترهای سوئدی کار کنه، برعکس انگلیسی که همه مدلها هنوز توش قویان، واسه سوئدی نیاز به چارچوب دقیق داریم تا مدلها رو سختگیرانه و با دقت بسنجیم. چون مسائل زبانشناسی و حتی فرهنگ پزشکی خیلی تو کشورها فرق میکنه. این تحقیق ثابت کرد که با وجود پیشرفت بالا، هنوز نمیشه راحت به هر مدل زبانی اعتماد کرد و باید حواسمون باشه چه مدلی رو برا کجا به کار میبریم؛ مخصوصاً برای سوئدیها که ذخیره اطلاعات پزشکی مخصوصبهخودشون رو دارن.

در کل SMLB نهفقط یه ابزار برای تست هوش مصنوعیه، بلکه یه مشوق واسه آدماست که بیان مشارکت کنن و این فضا رو بهتر کنن، تا فرداهایی که AI اومد بیمارستان با دست پر و خیال راحت همراه دکترای واقعی باشه! 😉

منبع: +