سلام رفقا! امروز میخوام در مورد یه ایده خفن توی مدلهای تولید تصویر از متن (یا همون Text-to-Image models) صحبت کنم. میدونید این مدلها، مثل همون چیزایی که شما بهشون یه جمله میدین و واستون تصویر میسازن؟ مثلاً میگی: «گربهای که عینک زده رو کنار پنجره نشون بده»، بعد یه تصویر بامزه از گربه میسازی! اما یه مشکل با این مدلها هست – خیلی به نحوه جزئیات جملهای که میدی حساسن! مثلاً اگه کوچکترین تغییر توی جمله بدی، خروجی مدل جوری میشه که انگار کل دستور رو عوض کردی یا یه چیز عجیب و غریب درمیاد.

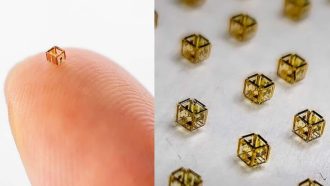

خلاصه یه گروه از محققها اومدن گفتن: «بیاید یه کار کنیم این مدلها موقع تولید تصویر بهتر بفهمن چی خواستیم و تصویر دقیقتری بسازن.» این ایده جدید اسمش TIR هست، که مخفف Test-time prompt refinement میشه. یعنی چی؟ یعنی موقع تست کردن و استفاده از مدل (نه موقع آموزش و یادگیری)، هی بیاییم دستور یا همون prompt رو اصلاح کنیم تا مدل خروجی بهتری بده.

حالا چطوری کار میکنه؟ پرسهش دور خودش میچرخه! بهش میگن closed-loop، یعنی سیستم خودش سعی میکنه ایرادها رو پیدا کنه و رفعشون کنه. اول شما یه دستور به مدل میدی، اونم یه عکس درست میکنه. بعد یه مدل دیگه وارد عمل میشه: اینجا از یه مدل زبون بزرگ چندرسانهای استفاده میکنن، بهش میگن MLLM. این MLLM یه هوش مصنوعی باحاله که هم متن سرش میشه هم تصویر رو میفهمه – یعنی میتونه الان بررسی کنه ببینه چیزی که خواستین و تصویری که ساختن واقعاً بهم میخورن یا نه.

مثلاً فرض کن تو دستور دادی «سگ قرمز با کلاه سبز جلوی کلیسا»، ولی مدل تصویرسازی یهو سگ رو بدون کلاه ساخته. اینجاست که مدل MLLM میاد وسط و این ناهماهنگی (misalignment یعنی همون مغایرت بین خواسته و نتیجه) رو تشخیص میده. بعد خودش یه بار دیگه دستور رو جوری بازنویسی میکنه که بهتر و جزئیتر باشه، به مدل تصویرساز میده، دوباره عکس جدید میسازه. این چرخه همینجوری تکرار میشه تا بالاخره عکس خروجی واقعاً اون چیزی باشه که خواسته بودی، رو بده.

یه جورایی میشه گفت این فرآیند مثل کار یه هنرمند آدمیزاد میمونه! مثل اینکه یکی تصویر بکشه، بعد خودش یا یه نفر دیگه بیاد بگه: «اینو یه کم اینجوری کن، فلان جزئیات رو هم اضافه کن»، هی بهترش کنه، تا یه نتیجه خفن دربیاد.

حالا نکته باحال ماجرا اینجاست که برای این کار نیاز نیست مدل تصویرسازی رو دوباره آموزش بدن (train کنن). روی همون مدلهای فعلی که داریم (که حتی به عنوان جعبه سیاه یا black-box هم شناخته میشن، یعنی ما داخلشون رو نمیبینیم فقط ورودی میدیم و خروجی میگیریم) میتونیم این ترفند رو اعمال کنیم. بهش میگن plug-and-play یعنی هرجا بخوای میتونی به راحتی به مدلای مختلف وصلش کنی، بدون دردسر.

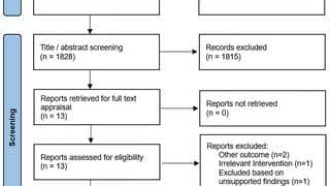

طبق آزمایشهایی هم که محققها انجام دادن (روی چندتا دیتاست معتبر که مردم معمولاً برای تست اینجور چیزا استفاده میکنن)، این راهکار واقعاً باعث میشه عکس خروجی هم با اون جمله اولیه شما هماهنگتر باشه و هم از نظر بصری (visual coherence یعنی تصویر یکدستی و منطقیتری داره) جذابتر دیده بشه.

در کل اگه شما اهل کار با هوش مصنوعی (AI) یا ساختن عکس با مدلهای متن به تصویر هستین باید بدونین با این راهکار TIR میتونین حسابی کیفیت و دقت کارتون رو بالاتر ببرین. هم کار باهاش راحته، هم نتایجش انصافاً بهتر دراومده. خلاصه اگر یه روزی دیدین مدل تصویرساز به حرفهاتون گوش نمیده، این روش اصلاح دستورات موقع تست میتونه نجاتتون بده!

اگه سوالی داشتین یا میخواین بیشتر بدونین، حتماً بپرسین! 😄

منبع: +