خب بذارین براتون از ThreadWeaver بگم، یه روش جدید و باحال که اومده مدلهای زبانی بزرگ (LLMها، یعنی همون هوش مصنوعیهایی که خودشون میتونن جمله بسازن و جواب بدن) رو حسابی سریعتر و باهوشتر کنه، مخصوصاً وقتی پای سوالای پیچیده وسطه.

قبل از هرچیز، یه مشکل داریم که خیلی بهش برخوردین: مدلهای زبانی معمولاً کارهاشون رو مرحلهبهمرحله (یا بهتر بگم، دونهبهدونه و پشت هم) انجام میدن. خب همین باعث میشه کلی وقت تلف شه، چون مجبورن هر بار منتظر تموم شدن یه بخش بمونن تا برن سراغ بعدی! اینجا ThreadWeaver وارد میشه.

چی کار میکنه ThreadWeaver؟

ایدهش اینه که سؤال رو تیکهتیکه کنه و هر بخش رو همزمان به چند تا “رشته” جداگونه بده تا همزمان روش فکر کنن. (اینو بهش میگن parallel reasoning یعنی فکر کردن موازی؛ وقتی چند قسمت مختلفِ یک کار رو به طور همزمان پیش میبری.) فازش اینه که هم سرعت رو زیاد میکنه، هم کیفیت جوابا نمیاد پایین.

خودش سه تا نوآوری اصلی داره:

۱. یه دستگاه درست کردن که تو دو مرحله کلی داده تمرینی باحال و باکیفیت به مدل میده، مخصوصاً دادههایی که توش رشتههای موازی مشخص شدن تا مدل یاد بگیره چطور در عمل موازی فکر کنه (CoT یا Chain-of-Thought یعنی وقتی مدل قدم به قدم دلایل خودش رو مینویسه).

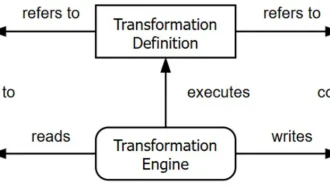

۲. سیستم آموزش و اجراش رو با یه چی به اسم trie طراحی کردن؛ trie یه جور ساختار دادهست (شبیه درخت که هر شاخهاش یه مسیر خاص رو نشون میده)، که باعث میشه مدلها روی هر موتور پیشبینی اتورگرسیو (autogressive inference engine – یعنی مدلهایی که مرحله به مرحله بعدی رو پیشبینی میکنن و خیلی استاندارن) اجرا بشن و لازم نشه بخشهای داخلی مدل مثلاً position embeddingها یا کش حافظهشون (KV caches) رو دستکاری کنی. خلاصه، کار باهاش راحته و لازم نیست ویژهسازی پیچیدهای بشه.

۳. و در نهایت، یادگیری تقویتی (Reinforcement Learning – یعنی مدلی که خودش یاد میگیره چطور بهتر بشه با آزمون و خطا) رو جوری پیاده کردن که به مدل بفهمونن کِی و چطور موازیسازی رو به فقط هرچه بیشتر کردن سرعت ترجیح بده، بدون اینکه دقت زیاد قربانی شه!

نتیجه آزمایشهاشون چی شد؟

روی شش تا آزمون ریاضی خیلی چالشبرانگیز، مدل ThreadWeaver رو روی Qwen3-8B (اینم یه مدل بزرگ زبانیه، مثل GPT-4 فقط مال یه شرکت دیگه) آموزش دادن. دقتش خیلی نزدیک مدلهای پیشرفته فعلی شد؛ مثلاً توی آزمون معروف AIME24، دقتش 79.9 درصد شد و به طور میانگین هم 71.9 درصد تونست جوابو درست بده. از طرفی، سرعتشم خیلی بهتر بود: میانگین تا 1.53 برابر سریعتر تونستن نتیجه بدن (اینو بهش میگن “سرعت تولید توکن”، هر توکن یعنی یه تیکه از یه کلمه یا جمله).

به زبان ساده: ThreadWeaver تونسته تعادلی بین دقت و سرعت بزنه که تا الان هیچکسی بهش نرسیده بود. یعنی هم جواباش به خوبی مدلهای زنجیرهای قدم به قدمه، هم خیلی سریعتر جواب میده. واسه شرکتا و کسایی که میخوان مدلهاشون هوشمند باشه اما معطلکن نباشه، ThreadWeaver یه حرکت خفن حساب میشه.

منبع: +