خب بچهها بگذارید یه تحقیق جالب رو براتون تعریف کنم! موضوعش اینه که وقتی دستگاهها (مثلاً موبایل یا لپتاپ) برامون با صدای مصنوعی یا همون TTS (Text-to-Speech یعنی فناوریای که متن رو به صدا تبدیل میکنه) جمله میخونن، چقدر راحت میتونیم جملههایی رو که دو زبانه گفتن بفهمیم؟ مخصوصاً انگلیسی و اسپانیایی، چون این دو تا زبان خیلی با هم ترکیب میشن.

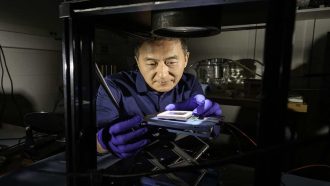

داستان از این قراره که محققها اومدن با دو روش متفاوت TTS، یعنی “نورال” (neural: یعنی از هوش مصنوعی خیلی پیشرفته استفاده میکنه تا صدا رو طبیعیتر بسازه) و “کنکاتنیتیو” (concatenative: یعنی وقتی صدای آدم رو تکهتکه کردن و بعد مثل پازل کنار هم میذارن تا یه جمله کامل دربیاد)، جملههایی رو ساختن و تست کردن.

توی این تحقیق، ۴۹ نفر که هردو زبان اسپانیایی و انگلیسی رو خوب بلد بودن، شرکت کردن. به این آدمها ۹۶ تا جمله پخش کردن که صداش با نویز (یعنی سر و صدای پسزمینه) مخلوط شده بود که آسون نباشه. نصف این جملهها “کدسوئیچ” بودن. کدسوئیچ یعنی وسط یه جمله، یهدفعه زبان عوض بشه – مثلاً جمله رو با انگلیسی شروع کنن و با اسپانیایی تموم کنن یا برعکس. نصف دیگه جملهها فقط یه زبانه بودن (یعنی یا کامل انگلیسی یا کامل اسپانیایی).

حالا وظیفه شرکتکنندهها این بود که آخر هر جمله، اون کلمه کلیدی آخر رو تایپ کنن تا ببینن چهقدر درست فهمیدن. جالبیش اینجاست که تعداد کلیدواژههای اسپانیایی و انگلیسی توی جملهها یکی بود.

نتیجه چی شد؟

اول اینکه جملههایی که آخرش کلمه کلیدی اسپانیایی داشتن، فهمیدنشون برای شرکتکنندهها سختتر بود. دوم اینکه هر وقت جملهها “کدسوئیچ” بودن، یعنی بین دو تا زبان سوئیچ شده بود، فهمشون باز هم سختتر میشد! یعنی اصل حرف اینکه، اگه یه جمله کامل انگلیسی یا کامل اسپانیایی باشه، راحتتر میشنویم و درست میفهمیم، اما وقتی وسطش زبان عوض میشه یا اسپانیایی باشه، احتمال خطا بیشتره.

این یافتهها برعکس یه سری تحقیقات قبلیه که میگفتن این مشکل تو حالت TTS به چشم نمیاد و عمدتاً فهم جمله ربطی به دو زبانه بودنش نداره. اما توی این تحقیق نشون دادن که مخصوصاً برای اسپانیایی توی جملههای کدسوئیچ یا دو زبانه، درک جمله سختتره.

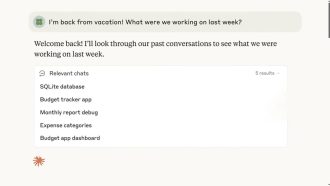

حالا چرا این مهمه؟ چون توی واقعیت، آدمهایی که دو تا زبان بلدن (اصطلاحاً بهشون “bilingual” میگن)، خیلی وقتها همین وسط جمله زبان رو عوض میکنن. پس اگه تکنولوژیهایی مثل voice AI (که همون دستیار صوتی هوشمنده) میخوان کاربردیتر و واقعیتر باشن، باید توی تشخیص این جملههای دو زبانه و مخصوصاً اسپانیایی بهتر بشن.

در کل دستاورد این تحقیق این بود که هنوز کلی جای پیشرفت برای TTSهای دو زبانه و هوش مصنوعیهای صوتی هست، مخصوصاً برای کسایی که هی زبان عوض میکنن یا در جامعههای چندزبانه زندگی میکنن. امیدوارم این یافتهها باعث بشه این تکنولوژیها بهتر و هوشمندتر شن!

منبع: +