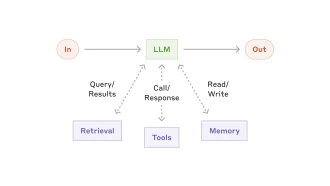

گیتهاب از گسترش قابل توجه دستیار کدنویسی کوپایلت خود با پشتیبانی از چندین مدل زبانی بزرگ (LLM) خبر داد. این تغییر استراتژیک، محیط توسعه هوش مصنوعی را متنوعتر و انعطافپذیرتر میکند.

این پلتفرم اکنون از چهار مدل زبانی جدید پشتیبانی میکند: Claude 3.5 Sonnet، Gemini 1.5 Pro و مدلهای o1-preview و o1-mini از OpenAI. مدلهای جدید OpenAI هماکنون در چت کوپایلت در دسترس هستند، Claude 3.5 Sonnet به زودی اضافه خواهد شد و Gemini 1.5 Pro در هفتههای آینده راهاندازی میشود.

این تکامل بر پایه مسیر گیتهاب کوپایلت از زمان راهاندازی اولیه با Codex شرکت OpenAI (بر پایه GPT-3) و نسخههای مختلف از جمله GPT-3.5 و GPT-4 بنا شده است. این شرکت قصد دارد قابلیت چند مدلی را در ویژگیهای متعددی از جمله فضای کاری کوپایلت، ویرایش چند فایلی، بازبینی کد، رفع خودکار مشکلات امنیتی و عملیات خط فرمان گسترش دهد.

همزمان با این گسترش، گیتهاب از ابزار هوش مصنوعی جدیدی به نام GitHub Spark رونمایی کرد که به توسعهدهندگان امکان میدهد با استفاده از زبان طبیعی، “میکرو اپلیکیشنها” را ایجاد کنند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: zdnet