پژوهشگران به پیشرفت چشمگیری در زمینه خودارزیابی مدلهای زبانی دست یافتهاند که به آنها امکان میدهد نیاز به کمک خارجی را تشخیص دهند. این قابلیت نوآورانه نشان میدهد که حتی مدلهای کوچکتر میتوانند با بهرهگیری از مکانیسمهای هوشمند خودارزیابی، عملکردی برابر یا بهتر از مدلهای بزرگتر داشته باشند.

پیشرفت قابل توجهی در هوش مصنوعی (AI) از تلاش مشترک پژوهشگران دانشگاه کالیفرنیا سن دیگو و دانشگاه تسینگهوا پدیدار شده است. رویکرد نوآورانه آنها بر آموزش مدلهای یادگیری زبان برای ارزیابی سطح اطمینان خود و تشخیص زمان نیاز به کمک خارجی متمرکز است.

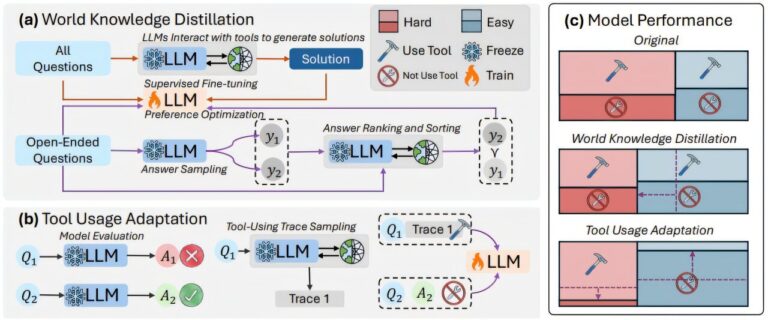

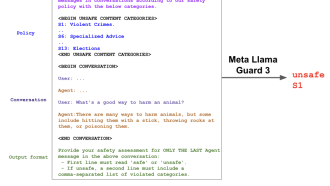

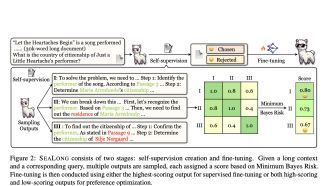

سیستم از طریق دو فاز یادگیری متمایز عمل میکند: «تقطیر دانش جهانی» (World Knowledge Distillation) که با استفاده از ابزارهای خارجی تخصص ایجاد میکند و «تطبیق استفاده از ابزار» (Tool Usage Adaptation) که سطوح اطمینان را به سناریوهای حل مسئله اختصاص میدهد. این رویکرد دو فازی به مدلهای کوچکتر امکان میدهد با کارایی قابل توجهی عمل کنند.

آزمایشها نتایج چشمگیری را نشان داد، به طوری که یک مدل با ۸ میلیارد پارامتر، بهبود ۲۸.۱۸ درصدی در دقت پاسخدهی و افزایش ۱۳.۸۹ درصدی در دقت استفاده از ابزار را نشان داد. این یافتهها پارادایم سنتی «بزرگتر بهتر است» در توسعه مدلهای زبانی بزرگ (LLM) را به چالش میکشد و نشان میدهد که بهبودهای استراتژیک در قابلیتهای تصمیمگیری میتواند بر مزایای اندازه خام برتری داشته باشد.

پژوهش محققان ثابت میکند که تقویت توانایی مدلهای زبانی بزرگ (LLM) در خودارزیابی و استفاده راهبردی از منابع خارجی میتواند سیستمهای کارآمدتر و دقیقتری را بدون نیاز به افزایش عظیم در اندازه مدل ایجاد کند. این پیشرفت میتواند نحوه رویکرد ما به توسعه هوش مصنوعی را با تمرکز بر سیستمهای هوشمندتر به جای سیستمهای بزرگتر، بازسازی کند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: techxplore.com