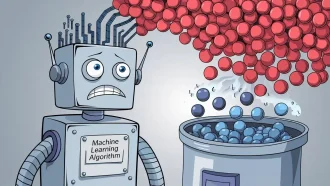

در حالی که مدلهای هوش مصنوعی مولد به سرعت پیشرفت میکنند، پدیدهای متناقض توجه متخصصان را به خود جلب کرده است: کاهش قابلیت اطمینان همزمان با افزایش توانمندیها. این تناقض در قابلیت اطمینان هوش مصنوعی مولد، مفروضات اساسی ما درباره مسیر توسعه این فناوری را به چالش میکشد و ضرورت بازنگری در معیارهای ارزیابی عملکرد را برجسته میسازد.

مطالعات اخیر روندی نگرانکننده را در دنیای هوش مصنوعی آشکار کردهاند: همزمان با بزرگتر و پیچیدهتر شدن مدلهای هوش مصنوعی مولد، قابلیت اطمینان آنها به طور غیرمنتظرهای رو به کاهش میگذارد. این پدیده، پیشفرضهای اساسی ما درباره توسعه هوش مصنوعی را به چالش میکشد و پرسشهای مهمی را درباره نحوه سنجش و درک عملکرد هوش مصنوعی مطرح میکند.

درک قابلیت اطمینان در هوش مصنوعی

قابلیت اطمینان در سیستمهای هوش مصنوعی به معنای ثبات در درستی خروجیهای آنهاست. زمانی که کاربران با پلتفرمهایی مانند ChatGPT، Claude یا Gemini تعامل میکنند، انتظار پاسخهای دقیق و ثابت دارند. با این حال، سنجش این قابلیت اطمینان بهویژه در مواردی که سیستمهای هوش مصنوعی از پاسخ به سؤالات خودداری میکنند، پیچیدهتر شده است.

سه دسته پاسخ

پاسخهای هوش مصنوعی معمولاً در سه دسته قرار میگیرند:

۱. پاسخهای درست

۲. پاسخهای نادرست

۳. پاسخهای اجتناب شده (امتناع از پاسخ)

معمای امتیازدهی

بحث کنونی بر چگونگی امتیازدهی به این پاسخهای اجتناب شده متمرکز است. دو رویکرد اصلی وجود دارد:

– برخورد با اجتنابها به عنوان خنثی (بدون جریمه)

– محسوب کردن اجتنابها به عنوان پاسخهای نادرست

روششناسی امتیازدهی

این روششناسی امتیازدهی تأثیر قابل توجهی بر درک ما از قابلیت اطمینان هوش مصنوعی (AI) دارد. تحقیقات اخیر نشان میدهد که هر چه مدلهای هوش مصنوعی پیچیدهتر میشوند و برای پاسخ به سؤالات بیشتر تحت فشار قرار میگیرند، درصد پاسخهای نادرست به طور قابل توجهی افزایش مییابد.

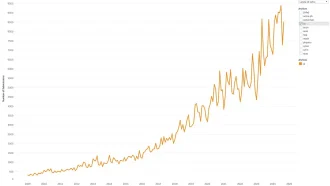

واقعیت آماری

با استفاده از یک مثال عملی از ۱۰۰ سؤال:

سناریوی اولیه:

– ۶۰ پاسخ صحیح

– ۱۰ پاسخ نادرست

– ۳۰ سؤال اجتناب شده

– دقت ظاهری: ۶۰٪

پس از اجبار به پاسخدهی بیشتر:

– ۷۰ پاسخ صحیح

– ۲۰ پاسخ نادرست

– ۱۰ سؤال اجتناب شده

– معیارهای دقت جدید نتایج متفاوتی را نشان میدهند

در حالی که تعداد کل پاسخهای صحیح افزایش یافته است، دو برابر شدن پاسخهای نادرست سؤالات جدی در مورد قابلیت اطمینان واقعی مطرح میکند.

پیامدهای آینده

این پارادوکس چالش مهمی را برای توسعه هوش مصنوعی مطرح میکند:

– آیا باید به اجازه اجتناب بیشتر بازگردیم؟

– آیا باید الزامات سختگیرانه پاسخدهی را حفظ کنیم؟

– چگونه میتوانیم بین دقت و کارایی تعادل برقرار کنیم؟

صنعت باید بهدقت در نظر بگیرد که چگونه معیارهای عملکرد هوش مصنوعی (AI) را اندازهگیری و منتقل کند، در حالی که شفافیت درباره موازنه بین قابلیت و قابلیت اطمینان را تضمین میکند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: forbes