امروزه فشردهسازی مدلهای زبانی عظیم به یکی از مهمترین چالشهای حوزه هوش مصنوعی تبدیل شده است. در این مقاله، سه تکنیک قدرتمند شامل هرسکردن مدل، کمیسازی و تقطیر دانش را بررسی میکنیم که میتوانند ضمن کاهش هزینههای محاسباتی، عملکرد سیستمهای هوش مصنوعی را به طور چشمگیری بهبود بخشند. با این راهکارهای عملی، میتوانید مدلهای خود را برای دستیابی به کارایی و سرعت بیشتر بهینه کنید.

در چشمانداز امروزی مبتنی بر هوش مصنوعی، سازمانها با چالشهای فزایندهای در زمینه تأخیر مدل، استفاده از حافظه و هزینههای محاسباتی روبرو هستند. با پیچیدهتر شدن مدلهای هوش مصنوعی، نیاز به راهبردهای فشردهسازی کارآمد برای حفظ عملکرد و کاهش نیازهای منابع، بسیار حیاتی میشود.

نیاز به فشردهسازی مدل

کاربردهای مدرن هوش مصنوعی نیازمند پردازش بلادرنگ برای موارد استفاده مختلف هستند:

– تشخیص تهدید

– پیشگیری از تقلب

– سیستمهای سوار شدن بیومتریک

– کاربردهای خدمات مشتری

سه استراتژی ضروری فشردهسازی

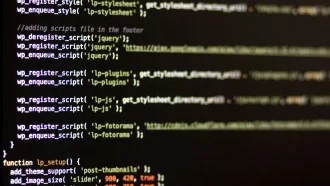

۱. هرسکردن مدل (Model Pruning)

- کاهش اندازه شبکه عصبی با حذف پارامترهای غیرضروری

- حفظ عملکرد در عین کاهش پیچیدگی محاسباتی

- امکان بهینهسازی تکراری برای تعادل بین اندازه و سرعت

- قابلیت آموزش مجدد برای بازیابی دقت

۲. کوانتیزاسیون مدل (Model Quantization)

- تبدیل اعداد اعشاری ۳۲ بیتی به اعداد صحیح ۸ بیتی

- دستیابی به بهبود تا ۴ برابری در حافظه و سرعت

- ایدهآل برای دستگاههای لبه (Edge) و کاربردهای موبایل

- قابلیت ترکیب با هرسکردن برای نتایج بهتر

- استفاده از مجموعهدادههای کالیبراسیون برای کاهش افت عملکرد

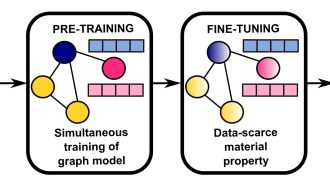

۳. تقطیر دانش (Knowledge Distillation)

- آموزش مدلهای “دانشآموز” کوچکتر برای تقلید از مدلهای “معلم” بزرگتر

- انتقال تصمیمها و الگوهای استدلال

- ارائه دقت مشابه با نیازهای محاسباتی کمتر

راهحلهای سنتی مانند آموزش مدلهای کوچکتر یا سرمایهگذاری در سختافزار پردازنده گرافیکی (GPU) گرانقیمت، اغلب مصالحههای قابل توجهی بین عملکرد و مقرونبهصرفه بودن ایجاد میکنند.

مزایای تکنیکهای فشردهسازی

- کاهش هزینه

- نیازمندیهای سختافزاری کمتر

- کاهش هزینههای رایانش ابری

- مصرف انرژی کمتر

- بهینهسازی عملکرد

- زمانهای استنتاج سریعتر

- پردازش بهبود یافته بلادرنگ

- تجربه کاربری ارتقا یافته

- گزینههای استقرار گستردهتر

- سازگاری با دستگاههای لبه (Edge)

- یکپارچهسازی با دستگاههای موبایل

- مقیاسپذیری بهبود یافته

ملاحظات پیادهسازی

برای پیادهسازی موفق راهبردهای فشردهسازی:

– ارزیابی نیازمندیهای موردی خاص

– متعادل کردن نیازهای عملکردی با محدودیتهای منابع

– در نظر گرفتن ترکیب چندین تکنیک فشردهسازی

– نظارت و حفظ دقت مدل

– آزمایش با مجموعه دادههای نمونه میتواند از طریق هرس و کمیسازی (Quantization) بیشتر بهینه شود

این راهکارهای فشردهسازی به سازمانها امکان میدهد تا راهکارهای هوش مصنوعی (AI) کارآمد را در عین حفظ استانداردهای عملکرد بالا به کار گیرند و پیادهسازی هوش مصنوعی را در کاربردهای مختلف، عملیتر و مقرون به صرفهتر سازند.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: venturebeat