مدلهای زبانی بصری به عنوان یکی از مهمترین پیشرفتهای اخیر در حوزه هوش مصنوعی، موفق شدهاند دقت جستجوی تصویری چندوجهی را تا ۲۸ درصد افزایش دهند. این فناوری نوین با ترکیب قابلیتهای پردازش زبان طبیعی و بینایی ماشین، راه را برای درک عمیقتر تصاویر توسط سیستمهای هوشمند هموار میکند و آینده تعامل انسان و ماشین را متحول میسازد.

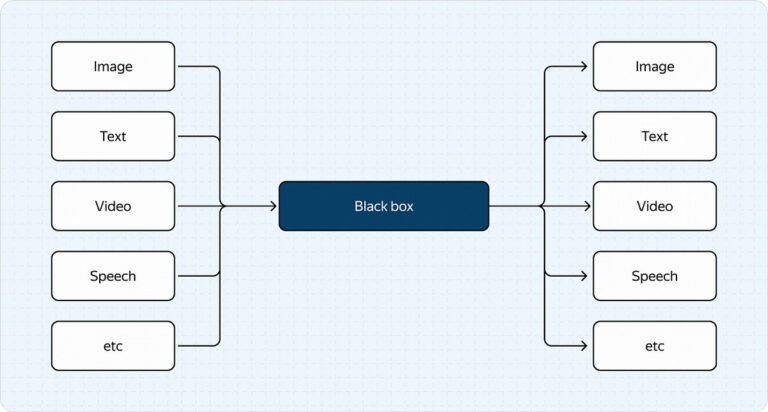

مدلهای زبانی بصری (VLM) نشاندهنده تحول قابل توجهی در هوش مصنوعی هستند که قابلیتهای پردازش زبان را با بینایی ماشین ترکیب میکنند. این یکپارچهسازی نقطه عطفی در گذر از مدلهای هوش مصنوعی سنتی با محدوده باریک است که تنها به پردازش زبان یا تصویر به صورت مجزا محدود بودند.

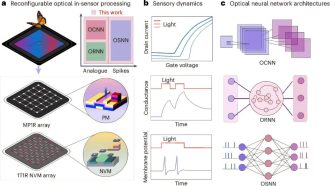

اجزای اصلی و معماری

VLM از سه عنصر اصلی تشکیل شده است:

– مدل زبانی (LLM)

– رمزگذار تصویر (Image Encoder)

– تطبیقدهنده (Adapter)

تبدیلکننده به عنوان میانجی حیاتی بین مدل زبانی بزرگ (LLM) و رمزگذار تصویر عمل میکند و از رویکردهای مبتنی بر پرامپت یا توجه متقابل استفاده میکند. تبدیلکنندههای مبتنی بر پرامپت، دادههای تصویری را به دنبالههای توکن تبدیل میکنند، در حالی که تبدیلکنندههای مبتنی بر توجه متقابل بر یکپارچهسازی ماتریسهای کلید/مقدار تمرکز دارند.

فرآیند آموزش

فرآیند آموزش مدل زبانی دیداری (VLM) شامل دو مرحله اصلی است:

۱. پیشآموزش

- پیشآموزش درهمتنیده

- پیشآموزش جفتهای تصویر-متن

- پیشآموزش مبتنی بر دستورالعمل

۲. تراز کردن

- تنظیم دقیق نظارتشده (SFT)

- یادگیری تقویتی اختیاری

پیادهسازی و نتایج

هنگام پیادهسازی در موتور جستجوی تصویری چندرسانهای، مدلهای زبانی دیداری بهبودهای قابل توجهی را نشان دادند:

– افزایش ۱۷٪ در جستجوهای مبتنی بر تصویر

– رشد ۴.۵٪ در تعامل جلسات کاربری

– بهبود ۲۸٪ در دقت کلی

روشهای ارزیابی کیفیت

عملکرد مدل زبانی دیداری از طریق موارد زیر ارزیابی میشود:

۱. معیارهای ارزیابی متنباز

۲. ارزیابیهای مقایسهای با تمرکز بر:

- دستور زبان

- خوانایی

- جامعیت

- ارتباط

- تشخیص خطا

- شناسایی توهم

کاربردهای عملی

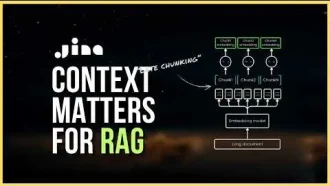

مدلهای زبانی بصری (VLM) در وظایف مختلفی برتری دارند، از جمله:

– توصیف تصویر

– تفسیر بصری

– حل مسائل پیچیده

– عملیات جستجوی چندوجهی

این فناوری بهویژه در بهبود قابلیتهای جستجو با ترکیب پردازش اطلاعات بصری و متنی موثر بوده و منجر به نتایج دقیقتر و جامعتر شده است.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: medium