قالببندی پرامپت (دستورات) در مدلهای زبانی بزرگ، تأثیری شگرف بر بهینهسازی و عملکرد ابزارهایی مانند GPT-3.5 و GPT-4 دارد. مطالعات اخیر نشان دادهاند که انتخاب قالب مناسب – از جمله متن ساده، Markdown یا JSON – میتواند دقت و ثبات این مدلها را به طور قابل توجهی افزایش دهد. درک این جنبهها، راههای جدیدی را برای متخصصان هوش مصنوعی باز میکند تا از پتانسیل کامل این مدلها بهرهمند شوند.

تأثیر پنهان قالببندی دستورات بر عملکرد مدلهای زبانی بزرگ

مدلهای زبانی بزرگ (Large Language Models: LLMs) مانند GPT-3.5 و GPT-4 شرکت OpenAI به ابزارهای متحولکنندهای در پردازش زبان طبیعی تبدیل شدهاند و در وظایفی از تولید محتوا گرفته تا تولید کد برتر هستند. با این حال، با گسترش قابلیتهای آنها، پیچیدگی بهینهسازی عملکرد آنها نیز افزایش مییابد. یک عامل جذاب اما کمتر بررسیشده که بر این مدلها تأثیر میگذارد، نحوه قالببندی دستورات است. این مطالعه به طور عمیق به چگونگی تأثیر چشمگیر انتخابهای ساختاری مانند متن ساده، Markdown، YAML یا JSON بر خروجی LLM میپردازد.

چرا قالببندی دستورات مهم است؟

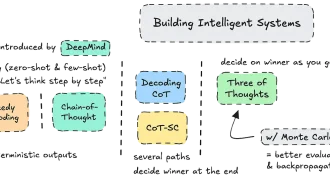

در حوزه LLMs، مهندسی دستورات اغلب به عنوان یک مهارت ضروری برای هدایت مدلها به سمت خروجیهای مطلوب مورد ستایش قرار میگیرد. در حالی که توجه زیادی به تکنیکهای پیشرفته مانند یادگیری در متن یا استدلال زنجیرهای معطوف شده است، قالببندی واقعی یک دستور نسبتاً کمتر بررسی شده است. این مطالعه این فرض را که عملکرد LLM از قالب مستقل است، به چالش میکشد و شواهدی را آشکار میکند که نشان میدهد تغییرات در ساختار دستور میتواند به طور قابل توجهی بر نتایج تأثیر بگذارد.

به عنوان مثال، اینکه یک دستور به صورت متن ساده نوشته شده باشد یا با استفاده از JSON یا Markdown ساختار یافته باشد، میتواند به طور مستقیم بر نحوه عملکرد LLM در یک کار تأثیر بگذارد. این بینش پیامدهای عمیقی برای توسعهدهندگان و محققانی دارد که هدفشان به حداکثر رساندن قابلیتهای مدلها است.

حساسیت: چگونه قالببندی نتایج را شکل میدهد

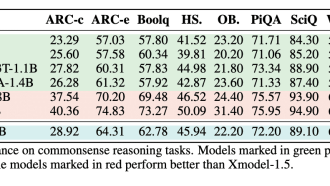

یکی از یافتههای قابل توجه این مطالعه، حساسیت بالای LLMs به قالببندی دستورات است. محققان وظایفی مانند استدلال زبان طبیعی، تولید کد و ترجمه را با استفاده از معیارهایی مانند CODEXGLUE و مجموعه دادههای MMLU ارزیابی کردند. نتایج نشان داد که تغییرات عملکرد تا ۴۰٪ فقط بر اساس سبک قالببندی است.

- مثال ترجمه کد: در وظایفی که شامل مجموعه دادههای CODEXGLUE بودند، GPT-3.5-turbo دقت بسیار بهتری را هنگام قالببندی دستورات با استفاده از JSON در مقایسه با متن ساده نشان داد.

- استدلال چند گزینهای: در مجموعه دادههای MMLU، دستورات قالببندی شده با JSON دقت GPT-3.5-turbo را به میزان ۴۲٪ افزایش دادند.

این یافتهها بر نیاز به طراحی دقیق دستورات تأکید میکند. انتخابهای قالببندی صرفاً ظاهری نیستند – آنها میتوانند توانایی مدل را برای ارائه خروجیهای با کیفیت بالا تقویت یا تضعیف کنند.

ثبات: پایداری در بین مدلها

فراتر از حساسیت، این مطالعه همچنین بررسی کرد که چگونه قالببندی بر ثبات پاسخ تأثیر میگذارد. مدلهای بزرگتر مانند GPT-4 در مقایسه با مدلهای کوچکتر مانند GPT-3.5-turbo پایداری بیشتری نشان دادند. هنگامی آزمایش در قالبهای مختلف، معیارها موارد زیر را نشان دادند:

- GPT-3.5-turbo در ثبات با مشکل مواجه شد و در مجموعه دادههای MMLU هنگام مقایسه پاسخها به قالبهای مختلف، امتیاز کمتر از ۰.۵ کسب کرد.

- از سوی دیگر، GPT-4 به امتیاز ثبات بالای ۰.۵ دست یافت که نشان دهنده خروجیهای قابل اعتمادتر در قالبهای مختلف است.

این نشان میدهد که در حالی که مدلهای بزرگتر ذاتاً قویتر هستند، کاملاً در برابر تغییرات ناشی از قالببندی مصون نیستند. برای متخصصان، انتخاب قالب مناسب هنگام کار با مدلهای کوچکتر یا کمتر پیشرفته، اهمیت بیشتری پیدا میکند.

قابلیت انتقال: هیچ راهحل یکسانی برای همه وجود ندارد

شاید جذابترین کشف این بود که هیچ قالب دستور بهینه جهانی برای همه وظایف و مدلها وجود ندارد. آنچه برای یک مدل خوب عمل میکند ممکن است برای مدل دیگری – حتی در همان خانواده مدلها – عملکرد ضعیفی داشته باشد.

- GPT-3.5-turbo: این مدل اغلب بهترین نتایج خود را با دستورات قالببندی شده با JSON ارائه میداد.

- GPT-4: جالب اینجاست که GPT-4 تمایل داشت با دستورات قالببندی شده با Markdown عملکرد بهتری داشته باشد.

برای کمی کردن این تنوع، محققان از معیارهای Intersection-over-Union (IoU) برای اندازهگیری همپوشانی در قالبهای برتر در بین وظایف و مدلهای مختلف استفاده کردند. نمرات پایین IoU نشان داد که قالبهای دستورات باید نه تنها برای کار، بلکه برای LLM خاص مورد استفاده نیز تنظیم شوند.

پیامدها برای متخصصان LLM

یافتههای این مطالعه پیامدهای قابل توجهی برای توسعهدهندگان، محققان و هر کسی که از LLMs در کار خود استفاده میکند، دارد:

- آزمایش ضروری است: به جای پایبندی به یک قالب واحد، متخصصان باید گزینههای مختلفی مانند متن ساده، Markdown، YAML یا JSON را آزمایش کنند تا مشخص کنند چه چیزی برای مورد استفاده خاص آنها بهترین عملکرد را دارد.

- بهینهسازی خاص مدل: از آنجایی که هیچ قالبی به طور جهانی کار نمیکند، دستورات باید هم برای کار و هم برای تکرار مدل خاص در حال استقرار تنظیم شوند.

- فرصتهای تحقیقاتی آینده: گسترش مطالعات برای شامل قالبهای اضافی مانند HTML یا XML میتواند بینش عمیقتری در مورد رفتار LLM به همراه داشته باشد. محققان همچنین ممکن است بررسی کنند که چگونه سایر تکنیکهای پیشرفته مانند استدلال زنجیرهای با حساسیت قالب تعامل دارند تا شیوههای قویتری را توسعه دهند.

نتیجهگیری نهایی

این مطالعه جنبهای از عملکرد LLM را که اغلب نادیده گرفته میشود، برجسته میکند: حساسیت آنها به قالببندی دستورات. در حالی که مدلهای بزرگتر مانند GPT-4 مقاومت بیشتری در برابر تغییرات قالببندی نشان میدهند، هیچ مدلی کاملاً تحت تأثیر این ظرافتهای ساختاری قرار نمیگیرد. برای توسعهدهندگان و محققان، این بر اهمیت طراحی دقیق دستورات متناسب با کار و مدل خاص مورد نظر تأکید میکند.

همانطور که مرزهای هوش مصنوعی را پیش میبریم، درک ظرافتهای نحوه ارتباط ما با این سیستمها حیاتی خواهد بود. انتخاب قالب دستور – متن ساده، Markdown، YAML یا JSON – ممکن است در نگاه اول بیاهمیت به نظر برسد، اما میتواند کلید دستیابی به حداکثر عملکرد در پروژه هوش مصنوعی بعدی شما باشد.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: arxiv