تا حالا فکر کردی هوش مصنوعیها (همین AIهایی که خودشون تصمیم میگیرن) هم ممکنه مثل آدمها دچار خطاهای ذهنی یا «کجفهمیهای شناختی» (cognitive bias یعنی همون اشتباهاتی که مغز ما تو تحلیل و قضاوت دچار میشه) بشن؟ خب این مقاله دقیقاً میره سراغ همین موضوع، و یه قاب جدید برای هک کردن سیستمهای خودران، مخصوصاً اونهایی که تو محیطهای پیچیده مثل پهپادها کار میکنن، معرفی میکنه!

حالا بذار قضیه رو سادهتر کنم. این سیستمهای هوشمند مثل پهپادهایی که خودشون تو آسمون تصمیم میگیرن چی رو رصد کنن، معمولاً یه سری راههای میانبر (بهش میگن heuristics یا «روشهای اولویتی») دارن که کمکشون میکنه سریعتر تصمیم بگیرن چی براشون مهمه و چه چیزی خطرناکه. ولی بدیِ این میانبرها اینه که باعث میشن سیستم دچار همون اشتباهاتی بشه که آدمها هم تجربه میکنن، مثل:

- «سالینس» (Salience): یعنی یه چیز بخصوص انقدر به چشم میاد که فکر میکنن مهمتره!

- «فریمبندی فضایی» (Spatial Framing): یعنی جای قرارگیری یه اتفاق روی توجهشون تاثیر میذاره.

- «آشنایی زمانی» (Temporal Familiarity): یعنی با هر بار تکرار شدن یه رویداد، هوش مصنوعی باهاش راحتتر میشه و حساسیتش رو از دست میده.

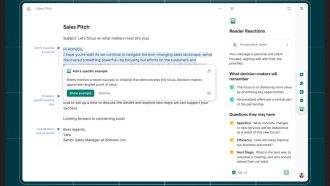

جالب شد؟ خب، محققها اومدن و یه روشی ساختن به اسم PRIOR یا «برعکس کردن اولویتها با استدلال عملیاتی» (Priority Inversion via Operational Reasoning). خیلی اسمش عجیب شد، ولی ساده بگم: یه راهیه که بدون تغییر دادن ورودی سیستم یا سر و کله زدن با جزییات تصویری، با کدهای ساختاری خاص (که خودشون معنی خاصی ندارن، فقط ساختارشون فرق داره) میشه به سیستم هوش مصنوعی حمله کرد و رد گم کرد!

یعنی با PRIOR شما با چندتا نشونه کوچیک و ساختاری، میتونین اولویت تصمیمگیری AI رو عوض کنین، جوری که مثلاً فکر کنه یه تهدید کوچیک، مهمتر از تهدید اصلیه. این کار هم بدون اینکه سیستم بفهمه کسی دارد تو کارش دست میبره انجام میشه (بهش میگن black-box inference attack یعنی حمله جعبه سیاه استنتاجی – یعنی از بیرون و بدون دیدن مغز سیستم بهش ضربه میزنن).

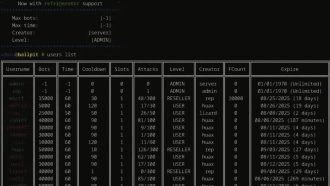

چون دسترسی به این سیستمهای واقعی خیلی سخته، اومدن یه راهنمای جایگزین گذاشتن: از مدلهای زبانی بزرگ (Large Language Models یا همون LLMها، مثل ChatGPT) به عنوان شبیهساز ذهن و استدلال AIها استفاده کردند. یعنی در واقع فرض کردند این مدلها خودشون مثل هوش مصنوعی پهپاد عمل میکنن و در یک سناریوی متنی شبیه شرایط واقعی، باید چک کنند کدوم تهدید مهمتره.

توی آزمایشها، معلوم شده که حتی با کمترین تغییر ساختاری توی سناریو (یعنی هیچ چیزی توی دادهها یا متن اصلی تغییر نکرده)، مدل هوش مصنوعی راحت گول میخوره و اولویتهاش قاطی میشه! مثلاً ممکنه تهدیدهای سطح پایین رو مهمتر فرض کنه و تهدید اصلی رو از یاد ببره. حتی وقتی ورودیها کاملاً یکسان و متقارن بودن، این جابجایی اولویت همچنان اتفاق میفتاد!

علاوه بر این، محققها با بررسی توضیحات مدلی که AI داده (توضیح اینکه چرا این انتخاب رو کرد) و میزان اعتمادی که مدل به جواب خودش داشته، فهمیدن که این خطا اصلاً سطحی نیست، بلکه یه ایراد ساختاریه.

نتیجه داستان؟ فهمیدیم که هوش مصنوعی فقط خروجی دادن درست کافی نیست؛ باید رفت سراغ مغز استدلالش و منطق اولویتبندیش وگرنه میتونه به راحتی توسط حملات خلاصه و زیرپوستی گول بخوره— اونم وسط عملیات واقعی و دینامیک! این موضوع تو سیستمهایی مثل رباتها، پهپادها و هر چی که خودمختار تصمیم میگیره خطرناک میشه.

پس درس این مقاله اینه: وقتی داریم هوش مصنوعیهایی میسازیم که خودشون تصمیم میگیرن یا تو محیطهای واقعی پرخطر فعالیت دارن، باید خیلی حواسمون به این باشه که فقط جواب صحیح مهم نیست؛ باید منطق استدلال داخلیشون رو هم دیباگ و تست کنیم تا گول ظاهر قشنگشون رو نخوریم!

منبع: +