پژوهشگران دانشگاه آلبرتا موفق به کشف محدودیت مهمی در سیستمهای یادگیری عمیق (Deep Learning) شدهاند: کاهش تدریجی توانایی یادگیری در طول زمان. این تیم همچنین یک الگوریتم جدید به نام پسانتشار مستمر (Continual Backpropagation) را برای حل این مشکل ارائه کردهاند.

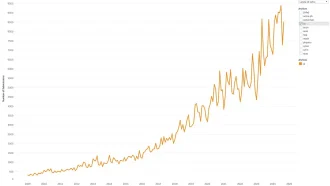

تیم تحقیقاتی به رهبری جی. فرناندو هرناندز-گارسیا و شیبهانش دوهاره نشان دادند که شبکههای عصبی مصنوعی (Artificial Neural Networks) پس از دورههای طولانی آموزش، کاهش انعطافپذیری – توانایی یادگیری اطلاعات جدید – را تجربه میکنند. این محدودیت برای سیستمهای هوش مصنوعی فعلی مانند ChatGPT پیامدهای قابل توجهی دارد، زیرا پس از آموزش اولیه “منجمد” میشوند و بدون بازآموزی گسترده و پرهزینه نمیتوانند از دادههای جدید یاد بگیرند.

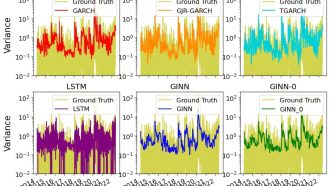

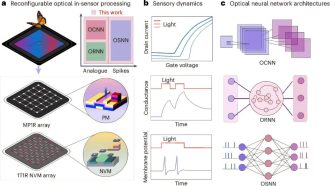

راهحل تیم، الگوریتم پسانتشار مستمر را معرفی میکند که با ارزیابی مداوم و راهاندازی مجدد کمکاربردترین نورونها در شبکه، انعطافپذیری را حفظ میکند. این رویکرد مشابه نوروژنز در مغز بیولوژیکی است و پیشرفت قابل توجهی نسبت به الگوریتم پسانتشار سنتی محسوب میشود.

دکتر روپام محمود، استاد دانشگاه و محقق هوش مصنوعی، بر اهمیت حیاتی این کشف تأکید میکند و خاطرنشان میسازد که ناتوانی سیستمهای یادگیری عمیق فعلی در یادگیری مستمر، مشکلی جدی است که نیاز به توجه دارد.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: ualberta.ca