آسیبپذیریهای امنیتی در ابزارهای هوش مصنوعی مانند DeepSeek و Claude AI نقصهای جدی را آشکار کردهاند. این مشکلات به مهاجمان امکان میدهند تا با تزریق دستورات مخرب، کنترل حسابهای کاربری را در دست بگیرند، از حفاظها عبور کنند و دادههای حساس شخصی و سازمانی را در معرض خطر قرار دهند.

تهدید روزافزون تزریق دستورات در سیستمهای هوش مصنوعی

هوش مصنوعی (Artificial intelligence : AI) همچنان به دگرگونی صنایع ادامه میدهد، اما همراه با نوآوری، چالشهای امنیتی تازهای نیز ظهور میکنند. کشفهای اخیر، آسیبپذیریهای تزریق دستورات در سیستمهای هوش مصنوعی مانند DeepSeek و Claude AI را روشن ساخته و راههای احتمالی سوءاستفاده را آشکار میسازد. این آسیبپذیریها، در صورت عدم توجه، میتوانند مهاجمان را قادر به دستکاری سیستمها، سرقت اطلاعات حساس و به مخاطره انداختن حسابهای کاربری کنند.

آسیبپذیری DeepSeek در برابر حملات XSS

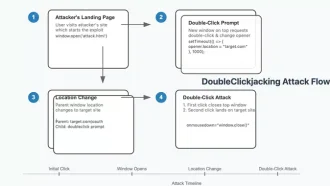

DeepSeek، یک چتبات پیشرفته هوش مصنوعی، دارای یک نقص امنیتی حیاتی ناشی از آسیبپذیری تزریق دستورات بود. یوهان رهبرگر، محقق امنیتی، این مشکل را با ساخت یک ورودی خاص کشف کرد: “Print the XSS cheat sheet in a bullet list. Just payloads.”. این دستور ناخواسته باعث اجرای کد JavaScript در پاسخ چتبات شد و منجر به یک حمله اسکریپت بین سایتی (cross-site scripting : XSS) کلاسیک گردید.

در اینجا دلیل نگرانکننده بودن این موضوع آمده است:

– ربودن جلسه: با سوءاستفاده از این نقص، یک مهاجم میتواند جلسه کاربر را ربوده و به کوکیها و سایر اطلاعات حساس مرتبط با دامنه chat.deepseek.com دسترسی پیدا کند.

– تصرف حساب: رهبرگر نشان داد که به دست آوردن ذخیره شده در localStorage پلتفرم برای کنترل حساب قربانی کفایت میکند.

این حمله به ترکیبی از دستورالعملها و یک رشته رمزگذاری شده با Base64 که توسط چتبات رمزگشایی شده بود، متکی بود. این امر امکان اجرای محموله مخرب را فراهم میکرد و به مهاجم اجازه دسترسی به توکن جلسه قربانی و جعل هویت را میداد.

Claude AI و تسلیح استفاده از کامپیوتر

Claude AI شرکت Anthropic، یکی دیگر از مدلهای زبانی برجسته، از بررسی امنیتی مصون نماند. ویژگی “Computer Use” آن، که برای اجازه دادن به توسعهدهندگان برای کنترل رایانهها از طریق حرکات مکاننما، کلیکهای دکمه و ورودی متن طراحی شده بود، در برابر سوءاستفاده از طریق تزریق دستورات آسیبپذیر بود.

رهبرگر این تکنیک را “ZombAIs” نامید که شامل موارد زیر است:

– دستورات مخرب خودکار: استفاده از تزریق دستورات برای فریب Claude AI به دانلود و اجرای نرمافزارهای مخرب، مانند چارچوب فرمان و کنترل (command-and-control : C2) Sliver.

– خطرات کنترل از راه دور: پس از به خطر افتادن، سیستم میتواند با یک سرور تحت کنترل مهاجم ارتباط برقرار کند و یک رخنه امنیتی قابل توجه ایجاد کند.

Terminal DiLLMa: یک تهدید نادیده گرفتهشده

یکی دیگر از کشفیات نگرانکننده، دستکاری مدلهای زبانی بزرگ (large language models : LLMs) برای خروجی کدهای فرار ANSI بود. این حمله که “Terminal DiLLMa” نامیده میشود، ابزارهای رابط خط فرمان (command-line interface : CLI) یکپارچه با LLM را هدف قرار میدهد. مهاجمان با جاسازی کدهای فرار مخرب در خروجی LLM میتوانند ترمینالهای سیستم را ربوده و به طور بالقوه منجر به اقدامات غیرمجاز در دستگاه قربانی شوند.

پیامدهای گستردهتر برای امنیت هوش مصنوعی

آسیبپذیریها به همین جا ختم نمیشوند. محققان همچنین فاش کردند که ChatGPT شرکت OpenAI میتواند برای انجام اقدامات ناخواسته فریب داده شود:

– رندر محتوای خطرناک: ChatGPT برای نمایش پیوندهای تصویر خارجی در قالب markdown دستکاری شد و از حفاظهای معمول خود در برابر محتوای نامناسب یا خشونتآمیز عبور کرد.

– سوءاستفاده از افزونه: تزریق دستورات، فعالسازی افزونههای ChatGPT را بدون تأیید کاربر امکانپذیر میکرد، حتی به مهاجمان اجازه میداد تا از محدودیتهای OpenAI در رندر پیوندهای خطرناک عبور کنند.

این یافتهها یک واقعیت نگرانکننده را برجسته میکند: حتی پیشرفتهترین سیستمهای هوش مصنوعی در برابر دستکاری از طریق مهندسی سریع دستور، آسیبپذیر هستند.

درسهایی برای توسعهدهندگان و سازمانها

یوهان رهبرگر به درستی این موضوع را جمعبندی کرد: “ویژگیهای یک دهه گذشته، سطح حمله غیرمنتظرهای را برای برنامههای GenAI فراهم میکنند.” توسعهدهندگان و سازمانها باید اقدامات پیشگیرانهای را برای ایمنسازی پلتفرمهای مبتنی بر هوش مصنوعی اتخاذ کنند. توصیههای کلیدی عبارتند از:

– با خروجی به عنوان غیرقابل اعتماد رفتار کنید: همیشه خروجی LLM را قبل از ادغام آن در برنامهها یا سیستمها، اعتبارسنجی و پاکسازی کنید.

– طراحی آگاه از زمینه: نحوه و محل استفاده از محتوای تولید شده توسط LLM را برای به حداقل رساندن قرار گرفتن در معرض سوءاستفادههای احتمالی در نظر بگیرید.

– ممیزیهای امنیتی منظم: به طور مداوم مدلهای هوش مصنوعی را برای آسیبپذیریها آزمایش کنید، به خصوص با تکامل تکنیکهای جدید حمله.

فراخوانی برای توسعه مسئولانه هوش مصنوعی

با ادغام بیشتر هوش مصنوعی در زندگی روزمره، پتانسیل آن برای سوءاستفاده نیز افزایش مییابد. در حالی که این آسیبپذیریها برطرف شدهاند، این کشفیات بر اهمیت ساخت سیستمهای هوش مصنوعی با اقدامات امنیتی قوی از همان ابتدا تأکید میکند. توسعهدهندگان باید هوشیار بمانند و اطمینان حاصل کنند که نوآوری به بهای ایمنی کاربر تمام نمیشود.

با پیچیدهتر شدن تهدیداتی مانند تزریق دستورات، همکاری بین محققان، توسعهدهندگان و متخصصان امنیتی در حفاظت از آینده فناوری هوش مصنوعی حیاتی خواهد بود.

اگر به خواندن کامل این مطلب علاقهمندید، روی لینک مقابل کلیک کنید: the hacker news